Usando a API de Pesquisa Web do Ollama em Go

Construa agentes de busca com IA usando Go e Ollama

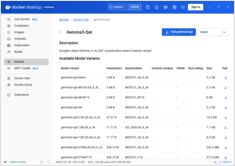

A API de pesquisa web do Ollama permite que você amplie LLMs locais com informações da web em tempo real. Este guia mostra como implementar capacidades de pesquisa web em Go, desde chamadas simples da API até agentes de pesquisa completos.