Construindo um BFF GraphQL com Apollo Server

Otimize APIs do frontend com GraphQL BFF e Apollo Server

O Backend for Frontend (BFF) combinado com GraphQL e Apollo Server cria uma arquitetura poderosa para aplicações web modernas.

Otimize APIs do frontend com GraphQL BFF e Apollo Server

O Backend for Frontend (BFF) combinado com GraphQL e Apollo Server cria uma arquitetura poderosa para aplicações web modernas.

Controle seus dados com o armazenamento em nuvem Nextcloud auto-hospedado

Nextcloud é a principal plataforma de armazenamento e colaboração em nuvem de código aberto e auto-hospedada que coloca você em completo controle dos seus dados.

dois poderosos sistemas de gestão do conhecimento

Escolher a ferramenta certa de Gestão do Conhecimento Pessoal (PKM) pode impactar significativamente sua produtividade, aprendizado e organização da informação. Vamos dar uma olhada em Obsidian e LogSeq.

Suas fotos no backup com IA hospedado localmente

Immich é uma solução revolucionária de gestão de fotos e vídeos de código aberto e auto-hospedada que lhe dá o controle total sobre suas memórias. Com recursos que rivalizam com o Google Photos, incluindo reconhecimento facial impulsionado por IA, pesquisa inteligente e backup automático móvel, tudo isso mantendo seus dados privados e seguros no seu próprio servidor.

Comandos do Elasticsearch para busca, indexação e análise

Elasticsearch é um poderoso motor de busca e análise distribuído construído sobre o Apache Lucene. Este cheatsheet abrangente abrange comandos essenciais, melhores práticas e referências rápidas para trabalhar com clusters Elasticsearch.

Benchmarks do GPT-OSS 120b em três plataformas de IA

Fui atrás de alguns testes de desempenho interessantes do GPT-OSS 120b em execução no Ollama em três plataformas diferentes: NVIDIA DGX Spark, Mac Studio e RTX 4080. O modelo GPT-OSS 120b da biblioteca Ollama tem 65GB, o que significa que ele não cabe na VRAM de 16GB de um RTX 4080 (ou no mais novo RTX 5080).

Testes em Python com pytest, TDD, mocking e coverage

Testes unitários garantem que seu código Python funcione corretamente e continue funcionando conforme seu projeto evolui. Este guia abrangente aborda tudo o que você precisa saber sobre testes unitários em Python, desde conceitos básicos até técnicas avançadas.

Construa servidores MCP para assistentes de IA com exemplos em Python

O Protocolo de Contexto do Modelo (MCP) está revolucionando a forma como os assistentes de IA interagem com fontes de dados externas e ferramentas. Neste guia, exploraremos como construir servidores MCP em Python, com exemplos focados nas capacidades de busca na web e raspagem.

Atalhos do teclado do Ubuntu -> sua produtividade

Atalhos do teclado do Ubuntu são ferramentas essenciais para maximizar a produtividade e a eficiência. Seja você um desenvolvedor, sysadmin ou usuário avançado, esses atalhos podem acelerar seu fluxo de trabalho e reduzir a dependência do mouse.

Python para converter HTML em Markdown limpo e pronto para LLM

Conversão de HTML para Markdown é uma tarefa fundamental nos fluxos de trabalho modernos de desenvolvimento, especialmente ao preparar conteúdo web para Grandes Modelos de Linguagem (LLMs), sistemas de documentação ou geradores de sites estáticos como o Hugo.

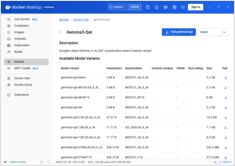

Referência rápida para comandos do Docker Model Runner

Docker Model Runner (DMR) é a solução oficial do Docker para executar modelos de IA localmente, introduzida em abril de 2025. Este guia rápido fornece uma referência rápida para todos os comandos essenciais, configurações e melhores práticas.

Compare Docker Model Runner e Ollama para LLM local

Executar modelos de linguagem grandes (LLMs) localmente tornou-se cada vez mais popular por motivos de privacidade, controle de custos e capacidades offline. O cenário mudou significativamente em abril de 2025, quando o Docker introduziu Docker Model Runner (DMR), sua solução oficial para implantação de modelos de IA.

Implante uma malha de serviço pronta para produção - Istio vs Linkerd

Descubra como implementar e otimizar arquiteturas de malha de serviço usando Istio e Linkerd. Este guia abrange estratégias de implantação, comparações de desempenho, configurações de segurança e melhores práticas para ambientes de produção.

Gerenciamento simples de VM para Linux com GNOME Boxes

No cenário atual da computação, a virtualização tornou-se essencial para desenvolvimento, testes e execução de múltiplos sistemas operacionais. Para usuários de Linux que buscam uma forma simples e intuitiva de gerenciar máquinas virtuais, GNOME Boxes destaca-se como uma opção leve e amigável ao usuário que prioriza a facilidade de uso sem sacrificar a funcionalidade.

Protocolo social descentralizado com mais de 21K usuários redefinindo a privacidade online

Aqui temos Nostr - o protocolo social descentralizado que está desafiando a dominação da Big Tech com comunicação resistente à censura e dados controlados pelo usuário.

Instalação, configuração e comandos essenciais de instalação multipass

Multipass é um gerenciador leve de máquinas virtuais que facilita a criação e o gerenciamento de instâncias de nuvem Ubuntu no Linux, Windows e macOS.