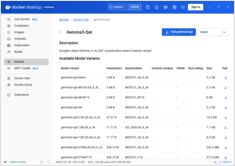

Hospedagem Local de LLM: Guia Completo de 2026 - Ollama, vLLM, LocalAI, Jan, LM Studio e Mais

Domine o implantação local de LLM com 12+ ferramentas comparadas

Implantação local de LLMs tornou-se cada vez mais popular, à medida que desenvolvedores e organizações buscam maior privacidade, menor latência e maior controle sobre sua infraestrutura de IA.