Farfalle vs Perplexica

Comparando duas ferramentas de busca por IA auto-hospedadas

Comida incrível é um prazer para os olhos também. Mas neste post, vamos comparar dois sistemas de busca baseados em IA, Farfalle e Perplexica.

De passagem, esta forma de massa também é chamada de “farfalle”.

Mas aqui estou comparando apenas como esses dois sistemas se comportam. Não as formas de massa.

OK. Concentre-se!

Por favor, veja também Instalação e configuração do Perplexica - com ollama e Instale e configure o Ollama.

Perplexica

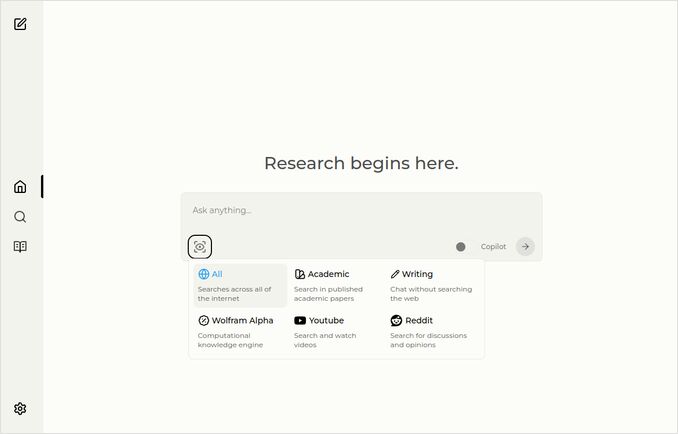

Aqui está a página inicial com o dropdown de seleção de fontes.

- O Perplexica é implementado em

- TypeScript e React.Js (UI)

- TypeScript e Express.Js (Backend)

- também inclui configuração para o motor de busca metasearch SearxNG

- Tem um modo Copilot

- Tem a capacidade de usar qualquer LLM hospedado no Ollama como modelo de chat ou embeddings

- Tem três pequenos modelos internos de embeddings

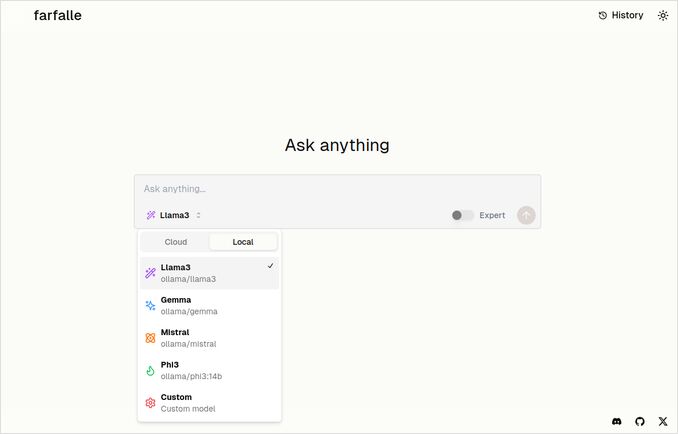

Farfalle

- A Farfalle é implementada em

- TypeScript e React.Js (UI)

- Python Fastapi (Backend)

- também inclui referência para o motor de busca metasearch SearxNG. Não há muito de configuração para isso, é uma imagem de docker padrão.

- Tem um modo Expert que deveria preparar várias solicitações a partir do original e combinar as respostas. Mas isso não funcionou no nosso teste.

- Tem a capacidade de usar quatro LLMs hospedados no Ollama como modelo de chat (llama3, mistral, gemma, phi3). Essa é uma boa seleção de opções, mas eu preferiria que fosse mais flexível e permitisse usar qualquer modelo que o Ollama servir.

- Nenhuma opção para modelos de embeddings

Comparação feita pelo próprio Perplexica e Farfalle

Executei a mesma solicitação Compare farfalle e perplexica com base em robustez, comunidade, suporte e LLM suportado

Ambos, Perplexica e Farfalle, estavam usando o modelo llama3 hospedado localmente no ollama. O nome completo do modelo é llama3 8b q4.

Não acredite 100% no que as respostas dizem, apenas veja o comprimento do texto, estrutura e qualidade geral da resposta.

Eu acredito aproximadamente 70%…

Resposta da comparação do Perplexica

Comparação entre Farfalle e Perplexica

Robustez

Farfalle: 8/10 - A Farfalle é uma popular engine de busca baseada em IA conhecida por sua confiabilidade e capacidade de lidar com consultas complexas. Ela tem uma forte base em processamento de linguagem natural (NLP) e aprendizado de máquina (ML). Embora não seja perfeita, a robustez da Farfalle está bem estabelecida.

Perplexica: 9/10 - O Perplexica é construído sobre o modelo Phi-3 da Meta AI, que foi projetado para robustez. Ele foi testado para fornecer respostas precisas mesmo quando enfrentado com perguntas ambíguas ou pouco claras. Sua capacidade de reescrever perguntas e adaptar-se a diferentes contextos torna-o uma engine de busca robusta.

Comunidade

Farfalle: 7/10 - A Farfalle tem uma comunidade dedicada de usuários que apreciam suas capacidades. Embora não tenha o mesmo nível de adoção que o Perplexica, a base de usuários da Farfalle ainda é significativa.

Perplexica: 8.5/10 - O Perplexica ganhou reconhecimento amplo por sua abordagem inovadora para engines de busca. Sua comunidade está crescendo rapidamente, com muitos usuários apreciando sua capacidade de fornecer resultados precisos e relevantes.

Suporte

Farfalle: 6.5/10 - A Farfalle fornece suporte básico por meio de FAQs, documentação e fóruns. Embora não seja tão abrangente quanto o suporte do Perplexica, a base de usuários da Farfalle geralmente é autossuficiente.

Perplexica: 9/10 - O Perplexica oferece recursos de suporte extensos, incluindo documentação detalhada, FAQs e fóruns da comunidade. Seus desenvolvedores estão ativamente envolvidos com a comunidade, garantindo que os usuários recebam assistência oportuna e eficaz.

LLMs Suportados

Farfalle: Não - A Farfalle é uma engine de busca baseada em IA autônoma que não depende de grandes modelos de linguagem (LLMs) para suas capacidades.

Perplexica: Sim - O Perplexica é construído sobre o modelo Phi-3 da Meta AI, que é um LLM. Isso permite que o Perplexica aproveite o poder do aprendizado de profundidade para resultados mais precisos e relevantes.

Pontuação geral Farfalle: 22/30 Perplexica: 34.5/40

Com base nesses critérios, o Perplexica parece ter uma vantagem leve sobre a Farfalle em termos de robustez, suporte comunitário e integração com LLM. No entanto, ambas as engines de busca têm suas próprias forças, e a escolha depende finalmente das suas necessidades e preferências específicas.

Recomendação Se você estiver procurando uma engine de busca baseada em IA confiável com fortes capacidades de NLP, o Perplexica pode ser a melhor escolha. Se você preferir uma abordagem mais direta e sem frivolidades para a busca, a Farfalle ainda pode fornecer resultados excelentes.

Resposta da comparação da Farfalle

Comparação entre Farfalle e Perplexica

A Farfalle e o Perplexica são duas engines de busca baseadas em IA que ganharam atenção recentemente. Aqui está uma comparação desses dois projetos com base em robustez, comunidade, suporte e suporte a LLM (Large Language Model).

Robustez

- A Farfalle foi projetada para ser auto-hospedada com LLMs locais ou na nuvem, tornando-a uma opção mais robusta para usuários que desejam controlar sua engine de busca.

- O Perplexica, por outro lado, é uma alternativa de código aberto ao Perplexity AI e está constantemente sendo aprimorada pelos seus desenvolvedores.

Comunidade

- O Perplexica tem uma comunidade dedicada de desenvolvedores e usuários que contribuem para seu desenvolvimento e fornecem suporte

- A comunidade da Farfalle é menor, mas ainda tem presença no GitHub

Suporte

- O Perplexica oferece atualizações e melhorias regulares, bem como um canal de Discord para discutir assuntos fora do suporte regular

- O suporte da Farfalle é limitado a problemas no GitHub e solicitações de pull

Suporte a LLMs Ambas, a Farfalle e o Perplexica, suportam LLMs. O Perplexica usa o Ollama, um LLM local, enquanto a Farfalle suporta tanto LLMs locais quanto na nuvem.

Em resumo, a Farfalle é mais robusta devido ao seu design auto-hospedado, enquanto o Perplexica tem uma comunidade mais forte e melhor suporte. Ambos os projetos suportam LLMs, mas o Perplexica usa especificamente o Ollama.

Conclusão

Qual é a diferença entre Perplexica e Farfalle?

A resposta:

- Ignorando alguns erros factuais, ambos os sistemas acreditam que o Perplexica é melhor que a Farfalle, o que eu gostaria de concordar.

- Eu realmente gosto da interface do usuário da Farfalle, embora estejam bastante próximas

- Eu gosto da ideia do modo expert da Farfalle, embora não tenha funcionado no meu ambiente

- Encontrei 3 bugs ao executar a Farfalle. O código do Perplexica é mais polido

- Uma vez configurado, o Perplexica funcionou sem erros

- O Perplexica permite usar qualquer modelo hospedado no Ollama. E a Farfalle permite usar apenas Gemma, Llama3, Mistral e Phi3 (versões predefinidas, que estão um pouco desatualizadas).

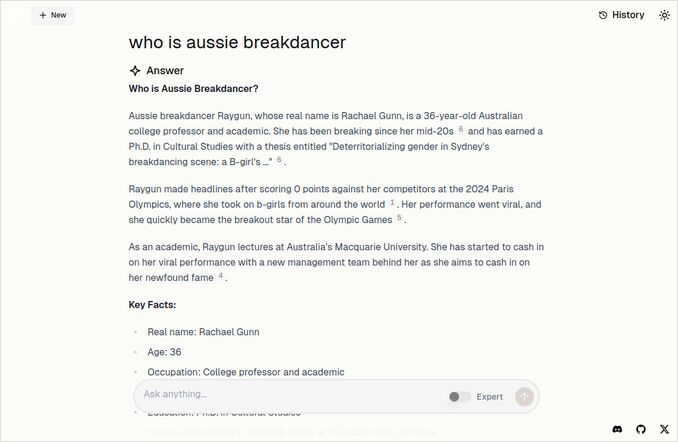

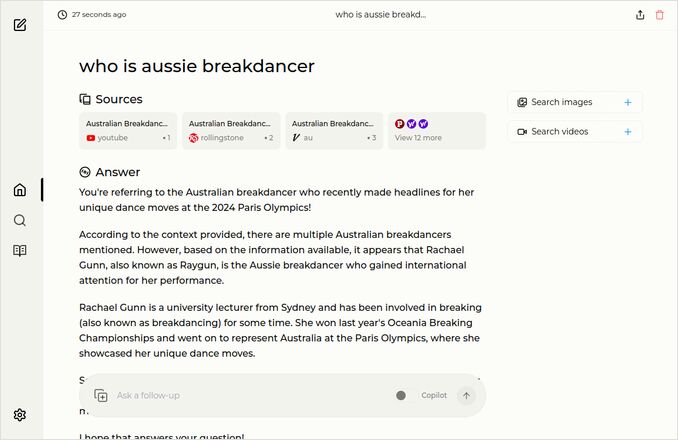

- Eu gosto mais das respostas da Farfalle. Veja a imagem da Farfalle abaixo. Direto ao ponto, sem aqueles “De acordo com o contexto fornecido”…

Mais exemplos

Esses mostram respostas para a mesma pergunta sobre o breakdancer australiano. Você sabe, aquele com PhD que obteve 0 (Zero) pontos e provavelmente teve o breakdancing removido do programa olímpico.

Resposta da Farfalle

Resposta do Perplexica

Se você ler (ou descer) até o último parágrafo, Obrigado por ter os mesmos interesses que eu. É realmente um tempo emocionante. Tenha um ótimo dia!

Links úteis

- Busca vs Deepsearch vs Deep Research

- Teste: Como o Ollama está usando o desempenho da CPU Intel e núcleos eficientes

- Como o Ollama lida com solicitações paralelas

- Auto-hospedagem do Perplexica - com Ollama

- Comparando as capacidades de resumo de LLM

- Escrevendo prompts eficazes para LLMs

- Testando a detecção de falácias lógicas por novos LLMs: gemma2, qwen2 e mistral Nemo

- Dica rápida do Ollama

- Dica rápida do Markdown

- Fornecedores de LLM na nuvem

- Modelos de embedding e reranker Qwen3 no Ollama: desempenho de ponta