Porównanie asystentów do kodowania AI

Cursor AI vs GitHub Copilot vs Cline AI vs...

W tym miejscu wymienię niektóre narzędzia wspomagane przez AI do kodowania oraz asystentów kodowania opartych na AI i ich pozytywne strony.

Cursor AI vs GitHub Copilot vs Cline AI vs...

W tym miejscu wymienię niektóre narzędzia wspomagane przez AI do kodowania oraz asystentów kodowania opartych na AI i ich pozytywne strony.

Krótki wykaz dostawców LLM

Użycie modeli językowych (LLM) nie jest bardzo drogie, może nie być potrzeby zakupu nowego, wspaniałego GPU.

Oto lista dostawców LLM w chmurze: dostawcy LLM w chmurze z LLM, które hostują.

Ollama na procesorze Intel CPU: wydajność w porównaniu do rdzeni o wysokiej wydajności

Mam teorię do przetestowania – czy wykorzystanie Wszystkich rdzeni na procesorze Intel zwiększy szybkość LLM? Denerwuje mnie fakt, że nowy model gemma3 27 bit (gemma3:27b, 17 GB na ollama) nie mieści się w 16 GB VRAM mojej karty graficznej i częściowo działa na procesorze.

AI wymaga dużo mocy...

Wśród burzy współczesnego świata tutaj porównuję specyfikację techniczną różnych kart odpowiednich do zadań AI

(uczenia maszynowego,

wykrywania obiektów

i modeli językowych).

Są one jednak ogromnie drogie.

Konfigurowanie ollama do wykonywania równoległych żądań.

Gdy serwer Ollama otrzymuje dwa żądania w tym samym czasie, jego zachowanie zależy od konfiguracji i dostępnych zasobów systemowych.

Co to jest ta nałogowa programowanie wspomagana AI?

Vibe coding to podejście do programowania napędowane przez sztuczną inteligencję, w którym programiści opisują pożądaną funkcjonalność w języku naturalnym, pozwalając narzędziom AI na automatyczne generowanie kodu.

Porównanie dwóch modeli deepseek-r1 do dwóch modeli bazowych

Model pierwszego pokolenia DeepSeek z porównywalną wydajnością do OpenAI-o1, w tym sześć gęstych modeli oddestylowanych z DeepSeek-R1 opartych na Llama i Qwen.

Skompilowałem tę listę poleceń Ollama kilka czasem temu...

Oto lista i przykłady najbardziej przydatnych poleceń Ollama (Ollama commands cheatsheet) Złożyłem ją kilka czasów temu, ostatnio zaktualizowana w styczniu 2026. Mam nadzieję, że będzie również użyteczna dla Ciebie.

Następny etap testów LLM

Nieco wcześniej wydano. Przejdźmy do rzeczy i

testuj jak Mistral Small poradzi sobie w porównaniu do innych LLM.

Kod Pythona do ponownego rangowania RAG'a

Świetny nowy model AI do generowania obrazu na podstawie tekstu

Niedawno Black Forest Labs opublikowała zestaw modeli AI tekst-do-obrazu text-to-image AI models.

Te modele mają być znane z znacznie wyższej jakości wyjściowych obrazów.

Spróbujmy ich

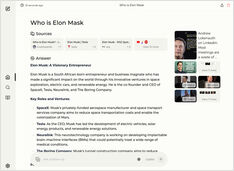

Porównanie dwóch samodzielnie hostowanych silników wyszukiwania AI

Świetna jedzenie to przyjemność dla oczu również. Ale w tym poście porównamy dwa systemy wyszukiwania oparte na AI, Farfalle i Perplexica.

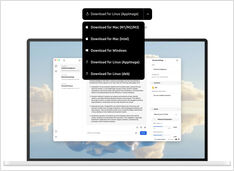

Uruchamianie lokalnego usługi w stylu Copilot? Łatwe!

To bardzo ekscytujące! Zamiast wołać copilot lub perplexity.ai i opowiadać światu, czego szukasz, teraz możesz uruchomić podobną usługę na własnym komputerze lub laptopie!

Testowanie wykrywania błędnego rozumowania

Niedawno widzieliśmy kilka nowych LLM, które zostały wydane. Wspaniałe czasy. Sprawdźmy i zobaczmy, jak działają, gdy wykrywają błędy logiczne.

Nieco mniej do wyboru, ale nadal...

Kiedy zacząłem eksperymentować z LLM, interfejsy do nich były w aktywnym rozwoju, a teraz niektóre z nich są naprawdę dobre.

Wymaga pewnego doświadczenia, ale

Nadal istnieją pewne powszechne podejścia do pisania dobrych promptów, dzięki czemu LLM nie będzie się pogubił, próbując zrozumieć, czego od niego oczekujesz.