Wzorzec Saga w transakcjach rozproszonych – przykłady w Go

Transakcje w mikroserwisach z użyciem wzorca Saga

Wzorzec Saga oferuje eleganckie rozwiązanie, dzieląc transakcje rozproszone na serię lokalnych transakcji z kompensującymi działaniami.

Transakcje w mikroserwisach z użyciem wzorca Saga

Wzorzec Saga oferuje eleganckie rozwiązanie, dzieląc transakcje rozproszone na serię lokalnych transakcji z kompensującymi działaniami.

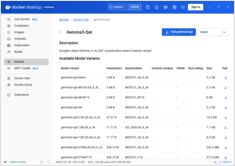

Włącz przyspieszenie GPU dla Docker Model Runner z obsługą NVIDIA CUDA

Docker Model Runner to narzędzie oficjalne Dockera do uruchamiania modeli AI lokalnie, ale włączanie przyspieszenia GPU od firmy NVidia w Docker Model Runner wymaga konkretnej konfiguracji.

Systemy przestrzegające prywatności z dowodami zero-wiedzy

Architektura zero-knowledge reprezentuje przełom w sposobie, w jaki projektujemy systemy zachowujące prywatność.

Kompletny przewodnik po zabezpieczeniach – dane w spoczynku, w trakcie przesyłania i w czasie wykonywania

Kiedy dane są cennym zasobem, ich ochrona nigdy nie była bardziej krytyczna.

Od momentu, gdy informacje są tworzone, aż do momentu, gdy są usuwane,

ich podróż jest pełna ryzyk – czy to przechowywane, przesyłane, czy aktywnie wykorzystywane.

Porównaj headless CMS – funkcje, wydajność i przypadki użycia

Wybór odpowiedniego headless CMS może zdecydować o sukcesie lub porażce Twojej strategii zarządzania treścią. Porównajmy trzy rozwiązania open source, które wpływają na to, jak programiści budują aplikacje oparte na treści.

Rozwój CLI w Go z użyciem frameworków Cobra i Viper

Interfejs wiersza poleceń (CLI) to istotne narzędzia dla programistów, administratorów systemów oraz specjalistów DevOps.

Dwie biblioteki w języku Go stały się standardem dla rozwoju CLI w Go: Cobra do struktury poleceń i Viper do zarządzania konfiguracją.

Zredukuj koszty LLM o 80% dzięki inteligentnej optymalizacji tokenów

Optymalizacja tokenów to kluczowe umiejętności, które oddzielają kosztowne aplikacje LLM od doświadczeń zużycia budżetu.

Architektura oparta na zdarzeniach z użyciem AWS Kinesis do skalowania

AWS Kinesis stał się fundamentem dla budowania nowoczesnych architektur mikroserwisów opartych na wydarzeniach, umożliwiając przetwarzanie danych w czasie rzeczywistym na dużą skalę z minimalnym nakładem operacyjnym.

Optymalizuj API前端 z użyciem GraphQL BFF i Apollo Server

Wzorzec Backend for Frontend (BFF) w połączeniu z GraphQL i Apollo Server tworzy potężną architekturę dla nowoczesnych aplikacji webowych.

Polecenia Elasticsearch do wyszukiwania, indeksowania i analizy

Elasticsearch to potężny rozproszony silnik wyszukiwania i analizy danych oparty na Apache Lucene. Ta kompletna lista poleceń obejmuje istotne polecenia, najlepsze praktyki oraz szybkie odniesienia do pracy z klastrami Elasticsearch.

Tworzenie serwerów MCP dla asystentów AI z przykładami w Pythonie

Protokół Kontekstu Modelu (MCP) rewolucjonizuje sposób, w jaki asystenci AI interagują z zewnętrznymi źródłami danych i narzędziami. W tym przewodniku omówimy, jak zbudować serwery MCP w Pythonie, z przykładami skupionymi na możliwościach wyszukiwania w sieci i skrapowania.

Szybki przewodnik po poleceniach Docker Model Runner

Docker Model Runner (DMR) to oficjalne rozwiązanie firmy Docker do uruchamiania modeli AI lokalnie, wprowadzone w kwietniu 2025 roku. Ten cheatsheet zawiera szybki przewodnik po wszystkich istotnych komendach, konfiguracjach i najlepszych praktykach.

Porównaj Docker Model Runner i Ollama dla lokalnego LLM

Uruchamianie dużych modeli językowych (LLM) lokalnie staje się coraz bardziej popularne ze względu na prywatność, kontrolę kosztów i możliwości offline. Landscape zmienił się znacząco w kwietniu 2025 roku, gdy Docker wprowadził Docker Model Runner (DMR), oficjalne rozwiązanie do wdrażania modeli AI.

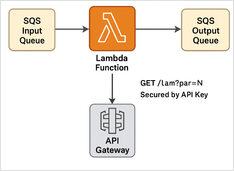

Przykład krok po kroku

Oto przykład Python Lambda do przetwarzania wiadomości SQS + interfejsu API REST z ochroną za pomocą klucza API + Terraform skryptu do wdrożenia w trybie bezserwerowym.

+ Konkretne Przykłady Używania Myślących LLMów

W tym wpisie omówimy dwa sposoby łączenia swojej aplikacji Python z Ollama: 1. Poprzez HTTP REST API; 2. Poprzez oficjalną bibliotekę Pythona dla Ollama.

Slightly different APIs require special approach. Slightly different APIs require special approach.

Oto porównanie wsparcia w formie obok siebie dla strukturalnego wyjścia (otrzymywanie niezawodnego JSON) wśród popularnych dostawców LLM, wraz z minimalnymi przykładami w Pythonie