16GB VRAM GPU용 최적의 LLM 추천

RTX 4080 16GB VRAM에서의 LLM 속도 테스트

대규모 언어 모델을 로컬에서 실행하면 프라이버시, 오프라인 기능, API 비용이 전혀 들지 않습니다. 이 벤치마크는 RTX 4080에서 실행되는 9개의 인기 있는 LLMs on Ollama에 대해 정확히 기대할 수 있는 내용을 보여줍니다.

RTX 4080 16GB VRAM에서의 LLM 속도 테스트

대규모 언어 모델을 로컬에서 실행하면 프라이버시, 오프라인 기능, API 비용이 전혀 들지 않습니다. 이 벤치마크는 RTX 4080에서 실행되는 9개의 인기 있는 LLMs on Ollama에 대해 정확히 기대할 수 있는 내용을 보여줍니다.

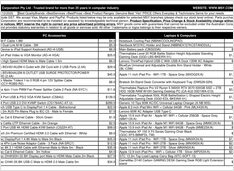

2025년 1월 GPU 및 RAM 가격 확인

오늘 우리는 최상위 소비자용 GPU와 RAM 모듈을 살펴보겠습니다.

구체적으로는

RTX-5080 및 RTX-5090 가격, 그리고 32GB (2x16GB) DDR5 6000을 살펴보겠습니다.

자신의 Linux 워크플로에 적합한 터미널을 선택하세요

Linux 사용자에게 가장 중요한 도구 중 하나는 터미널 에뮬레이터입니다. https://www.glukhov.org/ko/post/2026/01/terminal-emulators-for-linux-comparison/ “Linux 터미널 에뮬레이터 비교”

이제 호주 소매업체에서 제공하는 실제 AUD 가격

NVIDIA DGX Spark

(GB10 Grace Blackwell)은

호주에서 구매 가능

이며, 주요 PC 판매점에서 지역 재고가 있는 상태로 제공되고 있습니다.

글로벌 DGX Spark 가격 및 공급 상황에 관심이 있으셨다면, 글로벌 DGX Spark 가격 및 공급 상황을 참고하시면 좋습니다. 호주에서는 저장소 구성과 판매점에 따라 6,249 AUD에서 7,999 AUD 사이의 가격이 적용됩니다.

로컬 LLM을 사용하여 Cognee 테스트 - 실제 결과

Cognee는 문서에서 지식 그래프를 생성하기 위한 Python 프레임워크입니다. 하지만 이 프레임워크는 자체 호스팅된 모델과 호환되는가요?

우브untu에서 네트워크 문제를 해결한 방법

새로운 커널을 자동으로 설치한 후 Ubuntu 24.04에서 이더넷 네트워크가 사라짐 문제가 발생했습니다. 이 문제가 두 번째로 발생했기 때문에, 이 문제를 겪고 있는 다른 사람들에게 도움이 되기 위해 해결 방법을 여기에 기록해 두고자 합니다.

짧은 글로, 가격만 기록해 봅니다.

이번에는 이 광기적인 RAM 가격 변동성을 이해하고 더 명확한 그림을 만들기 위해 먼저 우리가 호주에서 RAM 가격 추적을 해보겠습니다.

AI 수요로 인한 공급 부족으로 RAM 가격이 163~619% 급등

2025년 말에 메모리 시장은 예상치 못한 가격 변동을 겪고 있으며, 모든 세그먼트에서 RAM 가격 상승이 극심하게 나타나고 있습니다.

AI에 적합한 소비자용 GPU 가격 - RTX 5080 및 RTX 5090

최상위 소비자용 GPU의 가격을 비교해 보겠습니다. 특히 LLM(대규모 언어 모델)에 적합하며, 일반적으로 AI에도 적합한 제품을 대상으로 합니다.

구체적으로 저는

RTX-5080 및 RTX-5090 가격을 살펴보고 있습니다.

예산 하드웨어에 오픈 모델을 사용하여 기업용 AI를 배포하세요.

AI의 민주화 시대가 도래했습니다.

Llama 3, Mixtral, Qwen과 같은 오픈소스 LLM이 이제는 전용 모델과 경쟁할 수 있을 정도로 발전했으며, 팀은 소비자 하드웨어를 사용하여 강력한 AI 인프라를 구축할 수 있습니다. 이는 비용을 절감하면서도 데이터 프라이버시와 배포에 대한 완전한 통제를 유지할 수 있습니다.

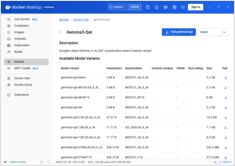

NVIDIA CUDA를 지원하는 Docker 모델 러너에 GPU 가속 기능을 활성화하세요.

Docker Model Runner은 로컬에서 AI 모델을 실행하기 위한 Docker의 공식 도구이지만, NVIDIA GPU 가속을 Docker Model Runner에서 활성화하기 위해서는 특정한 설정이 필요합니다.

GPT-OSS 120b의 세 개 AI 플랫폼에서의 벤치마크

Docker Model Runner 명령어의 빠른 참조

Docker 모델 러너 (DMR)는 2025년 4월에 도입된 Docker의 공식 솔루션으로, 로컬에서 AI 모델을 실행하는 데 사용됩니다. 이 체크리스트는 모든 필수 명령어, 구성 및 최선의 실천 방법에 대한 빠른 참조를 제공합니다.

GNOME Boxes를 사용한 Linux용 간단한 가상 머신 관리

현대 컴퓨팅 환경에서 가상화는 개발, 테스트, 여러 운영 체제의 실행에 필수적인 요소가 되었습니다. Linux 사용자들이 가상 머신을 관리하는 데 간단하고 직관적인 방법을 원한다면, GNOME Boxes는 기능성을 희생하지 않고 사용 편의성을 중시하는 가벼운 사용자 친화적인 옵션으로 두드러집니다.

전문적인 칩이 AI 추론을 더 빠르고 저렴하게 만들고 있습니다.

가용성, 6개 국가의 실제 소매 가격, Mac Studio와의 비교.

**NVIDIA DGX Spark**는 실제 제품이며, 2025년 10월 15일에 판매가 시작되며, CUDA 개발자들이 로컬 LLM 작업을 수행하기 위해 통합된 NVIDIA AI 스택이 포함된 제품을 대상으로 합니다. 미국 MSRP는 $3,999이며, 영국/독일/일본의 경우 VAT 및 채널 비용으로 인해 가격이 더 높습니다. AUD/KRW 공식 가격표는 아직 널리 공개되지 않았습니다.