16GB VRAM GPU용 최적의 LLM 추천

RTX 4080 16GB VRAM에서의 LLM 속도 테스트

대규모 언어 모델을 로컬에서 실행하면 프라이버시, 오프라인 기능, API 비용이 전혀 들지 않습니다. 이 벤치마크는 RTX 4080에서 실행되는 9개의 인기 있는 LLMs on Ollama에 대해 정확히 기대할 수 있는 내용을 보여줍니다.

RTX 4080 16GB VRAM에서의 LLM 속도 테스트

대규모 언어 모델을 로컬에서 실행하면 프라이버시, 오프라인 기능, API 비용이 전혀 들지 않습니다. 이 벤치마크는 RTX 4080에서 실행되는 9개의 인기 있는 LLMs on Ollama에 대해 정확히 기대할 수 있는 내용을 보여줍니다.

2026년 1월 인기 Python 저장소

이번 달의 Python 생태계는 Claude Skills과 AI 에이전트 도구로 주도되고 있습니다.

이 개요는 GitHub에서 인기 있는 Python 저장소에 대한 분석입니다.

올바른 Python 패키지 관리자를 선택하세요

이 포괄적인 가이드는 Anaconda, Miniconda, Mamba 비교에 대한 배경과 자세한 내용을 제공합니다. 이 세 가지 강력한 도구는 복잡한 의존성과 과학 컴퓨팅 환경을 사용하는 Python 개발자와 데이터 과학자에게 필수적이 되었습니다.

AI 생성 콘텐츠 감지 기술 가이드

AI 생성 콘텐츠의 확산은 새로운 도전을 만들었습니다: 진짜 인간의 글과 “AI slop” - 질이 낮고, 대량 생산된 합성 텍스트를 구분하는 것.

텍스트, 이미지 및 오디오를 공유된 임베딩 공간에 통합하세요.

크로스모달 임베딩은 인공지능 분야에서의 중요한 돌파구로, 다양한 데이터 유형을 하나의 통합된 표현 공간 내에서 이해하고 추론하는 것을 가능하게 합니다.

예산 하드웨어에 오픈 모델을 사용하여 기업용 AI를 배포하세요.

AI의 민주화 시대가 도래했습니다.

Llama 3, Mixtral, Qwen과 같은 오픈소스 LLM이 이제는 전용 모델과 경쟁할 수 있을 정도로 발전했으며, 팀은 소비자 하드웨어를 사용하여 강력한 AI 인프라를 구축할 수 있습니다. 이는 비용을 절감하면서도 데이터 프라이버시와 배포에 대한 완전한 통제를 유지할 수 있습니다.

데이터 과학 작업을 위한 Linux 환경 설정 방법을 마스터하세요.

Linux는 데이터 과학 전문가들이 사용하는 de facto 운영 체제가 되었으며, 비할 바 없이 유연한 성능, 풍부한 도구 생태계를 제공합니다.

파이썬을 사용한 ETS/MLOPS에 적합한 프레임워크

Apache Airflow은 프로그래밍적으로 워크플로우를 작성, 예약 및 모니터링할 수 있는 오픈소스 플랫폼으로, 완전히 파이썬 코드로 작성되어 전통적인, 수동적, 또는 UI 기반 워크플로우 도구보다 유연하고 강력한 대안을 제공합니다.

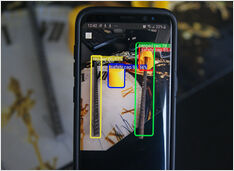

얼마 전에 저는 객체 감지 AI를 훈련시켰습니다.

한 여름의 추운 날, 호주에서는 여름이 아니라 겨울이죠…

AI 모델을 훈련하여 비캡된 콘크리트 강화 철근을 감지하는 것이 급한 필요성을 느꼈습니다…

LLM을 위해 두 번째 GPU를 설치하는 것을 고려 중이십니까?

PCIe 랜의 수가 LLM 성능에 미치는 영향? 작업에 따라 다릅니다. 훈련 및 다중 GPU 추론의 경우 성능 저하가 상당합니다.

AI는 많은 전력을 필요로 합니다...

현대 세계의 혼란 속에서 여기서 저는 다른 카드의 기술 사양을 비교를 AI 작업에 적합한 것으로 비교하고 있습니다.

(Deep Learning,

Object Detection

및 LLMs).

그러나 모두 매우 비싸네요.

MM* 도구의 전체 세트는 EOL에 도달했습니다...

저는 MMDetection (mmengine, mdet, mmcv)를 꽤 많이 사용해왔고,

이제는 그게 게임에서 벗어났다는 것 같네요.

유감스럽습니다. 저는 그 모델 저장소를 좋아했습니다.