Top 17 des projets Python tendance sur GitHub

Dépôts Python tendance de janvier 2026

L’écosystème Python de ce mois est dominé par les Claude Skills et les outils d’agents IA. Cette analyse examine les dépôts Python les plus populaires sur GitHub.

Dépôts Python tendance de janvier 2026

L’écosystème Python de ce mois est dominé par les Claude Skills et les outils d’agents IA. Cette analyse examine les dépôts Python les plus populaires sur GitHub.

Dépôts Go tendance de janvier 2026

L’écosystème Go continue de prospérer avec des projets innovants couvrant l’outillage IA, les applications auto-hébergées et l’infrastructure développeur. Ce panorama analyse les dépôts Go les plus tendance sur GitHub ce mois-ci.

Test de Cognee avec des LLMs locaux - résultats réels

Cognee est un framework Python pour construire des graphes de connaissances à partir de documents en utilisant des LLMs. Mais fonctionne-t-il avec des modèles auto-hébergés ?

Réflexions sur les LLMs pour l'auto-hébergement de Cognee

Choisir le Meilleur LLM pour Cognee demande de trouver un équilibre entre la qualité de construction de graphes, les taux d’hallucination et les contraintes matérielles. Cognee excelle avec des modèles plus grands et à faible taux d’hallucination (32B+) via Ollama, mais des options de taille moyenne conviennent aux configurations plus légères.

Construisez des agents de recherche IA avec Python et Ollama

La bibliothèque Python d’Ollama inclut désormais des capacités natives de recherche web Ollama. Avec quelques lignes de code, vous pouvez enrichir vos modèles locaux de LLM avec des informations en temps réel provenant du web, réduisant ainsi les hallucinations et améliorant la précision.

Choisissez le bon DB vectoriel pour votre pile RAG

Le choix du bon stockage vectoriel peut faire la différence entre le succès et l’échec de votre application RAG en termes de performance, de coût et d’évolutivité. Cette comparaison approfondie couvre les options les plus populaires en 2024-2025.

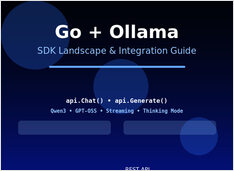

Construisez des agents de recherche IA avec Go et Ollama

L’API de recherche web d’Ollama vous permet d’augmenter les LLM locaux avec des informations en temps réel du web. Ce guide vous montre comment implémenter des capacités de recherche web en Go, des appels d’API simples aux agents de recherche complets.

Maîtrisez le déploiement local de LLM avec une comparaison de 12+ outils

Le déploiement local des LLMs (modèles de langage de grande taille) est devenu de plus en plus populaire alors que les développeurs et les organisations recherchent une meilleure confidentialité, une latence réduite et un contrôle accru sur leur infrastructure d’IA.

Déployez l'intelligence artificielle d'entreprise sur des matériels abordables avec des modèles open source

La démocratisation de l’IA est ici. Avec des LLM open source comme Llama 3, Mixtral et Qwen qui rivalisent désormais avec les modèles propriétaires, les équipes peuvent construire une infrastructure puissante d’IA à l’aide du matériel grand public - réduisant les coûts tout en maintenant un contrôle complet sur la confidentialité des données et le déploiement.

LongRAG, Self-RAG, GraphRAG - Techniques de nouvelle génération

Retrieval-Augmented Generation (RAG) a évolué bien au-delà de la simple recherche de similarité vectorielle. LongRAG, Self-RAG et GraphRAG représentent l’avant-garde de ces capacités.

Réduisez les coûts LLM de 80 % grâce à une optimisation intelligente des tokens

L’optimisation des tokens est la compétence critique qui distingue les applications LLM rentables des expériences coûteuses.

Python pour convertir HTML en Markdown propre et prêt à l'utilisation par un LLM

Conversion de HTML en Markdown est une tâche fondamentale dans les workflows de développement modernes, particulièrement lors de la préparation du contenu web pour les grands modèles de langage (LLM), les systèmes de documentation ou les générateurs de sites statiques comme Hugo.

Intégrez Ollama avec Go : guide de l'API, exemples et bonnes pratiques en production.

Ce guide fournit un aperçu complet des SDK Go pour Ollama disponibles et compare leurs ensembles de fonctionnalités.

Comparaison de la vitesse, des paramètres et des performances de ces deux modèles

Voici une comparaison entre Qwen3:30b et GPT-OSS:20b

se concentrant sur le suivi des instructions et les performances, les paramètres, les spécifications et la vitesse :

+ Exemples concrets utilisant des LLM de réflexion

Dans cet article, nous allons explorer deux façons de connecter votre application Python à Ollama : 1. Via HTTP REST API ; 2. Via la bibliothèque Python officielle d’Ollama.

Les API légèrement différentes nécessitent une approche spécifique.

Voici une comparaison côte à côte du support de sortie structurée (obtenir un JSON fiable) auprès des fournisseurs d’LLM populaires, ainsi que des exemples minimalistes en Python