Top 17 des projets Python tendance sur GitHub

Dépôts Python tendance de janvier 2026

L’écosystème Python de ce mois est dominé par les Claude Skills et les outils d’agents IA. Cette analyse examine les dépôts Python les plus populaires sur GitHub.

Dépôts Python tendance de janvier 2026

L’écosystème Python de ce mois est dominé par les Claude Skills et les outils d’agents IA. Cette analyse examine les dépôts Python les plus populaires sur GitHub.

Dépôts Rust tendance de janvier 2026

L’écosystème Rust explose avec des projets innovants, en particulier dans les outils de codage en IA et les applications terminales. Ce panorama analyse les dépôts Rust les plus tendance sur GitHub ce mois-ci.

Dépôts Go tendance de janvier 2026

L’écosystème Go continue de prospérer avec des projets innovants couvrant l’outillage IA, les applications auto-hébergées et l’infrastructure développeur. Ce panorama analyse les dépôts Go les plus tendance sur GitHub ce mois-ci.

Tarification réelle de l'AUD par les détaillants australiens maintenant

Le NVIDIA DGX Spark (GB10 Grace Blackwell) est maintenant disponible en Australie chez les principaux détaillants de PC avec des stocks locaux. Si vous avez suivi les prix et disponibilités mondiaux du DGX Spark, vous serez intéressé de savoir que les prix australiens vont de 6 249 à 7 999 AUD selon la configuration de stockage et le détaillant.

Réduisez les coûts LLM de 80 % grâce à une optimisation intelligente des tokens

L’optimisation des tokens est la compétence critique qui distingue les applications LLM rentables des expériences coûteuses.

Construisez des serveurs MCP pour des assistants IA avec des exemples en Python

Le protocole de contexte du modèle (MCP) révolutionne la manière dont les assistants IA interagissent avec des sources de données externes et des outils. Dans ce guide, nous explorerons comment construire des serveurs MCP en Python, avec des exemples axés sur les capacités de recherche web et de scraping.

Disponibilité, prix de vente au détail dans le monde réel dans six pays, et comparaison avec le Mac Studio.

NVIDIA DGX Spark est réel, disponible à la vente le 15 octobre 2025, et ciblé aux développeurs CUDA ayant besoin de travail local avec des LLM avec une pile AI NVIDIA intégrée. Prix de vente au détail aux États-Unis $3 999 ; le prix de vente au détail UK/DE/JP est plus élevé en raison de la TVA et des canaux. Les prix publics AUD/KRW ne sont pas encore largement affichés.

Intégrez Ollama avec Go : guide de l'API, exemples et bonnes pratiques en production.

Ce guide fournit un aperçu complet des SDK Go pour Ollama disponibles et compare leurs ensembles de fonctionnalités.

Comparaison de la vitesse, des paramètres et des performances de ces deux modèles

Voici une comparaison entre Qwen3:30b et GPT-OSS:20b

se concentrant sur le suivi des instructions et les performances, les paramètres, les spécifications et la vitesse :

+ Exemples concrets utilisant des LLM de réflexion

Dans cet article, nous allons explorer deux façons de connecter votre application Python à Ollama : 1. Via HTTP REST API ; 2. Via la bibliothèque Python officielle d’Ollama.

Peu agréable.

Les modèles GPT-OSS d’Ollama rencontrent régulièrement des problèmes pour gérer les sorties structurées, surtout lorsqu’ils sont utilisés avec des cadres comme LangChain, OpenAI SDK, vllm et d’autres.

Les API légèrement différentes nécessitent une approche spécifique.

Voici une comparaison côte à côte du support de sortie structurée (obtenir un JSON fiable) auprès des fournisseurs d’LLM populaires, ainsi que des exemples minimalistes en Python

Quelques façons d'obtenir une sortie structurée d'Ollama

Les grands modèles de langage (LLMs) sont puissants, mais en production, nous souhaitons rarement des paragraphes libres. Au contraire, nous voulons des données prévisibles : des attributs, des faits ou des objets structurés que vous pouvez alimenter dans une application. C’est la sortie structurée des LLM.

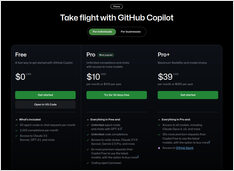

Description, liste des commandes et raccourcis clavier

Voici une feuille de rappels à jour sur GitHub Copilot, couvrant les raccourcis essentiels, les commandes, les conseils d’utilisation et les fonctionnalités de contexte pour Visual Studio Code et Copilot Chat

Longue lecture sur les spécifications et l'implémentation de MCP en GO

Ici, nous avons une description du Model Context Protocol (MCP), des notes brèves sur la manière d’implémenter un serveur MCP en Go, comprenant la structure des messages et les spécifications du protocole.

Mise en œuvre de RAG ? Voici quelques extraits de code en Go - 2...

Comme Ollama standard ne dispose pas d’API de rerank directe, vous devrez implémenter le reranking avec Qwen3 Reranker en GO en générant des embeddings pour les paires de requêtes et de documents et en les notant.