Mejores LLMs para Ollama en GPU con 16 GB de VRAM

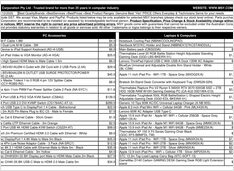

Prueba de velocidad de LLM en RTX 4080 con 16 GB de VRAM

Ejecutar modelos de lenguaje grandes localmente te brinda privacidad, capacidad para trabajar sin conexión y cero costos de API. Este benchmark revela exactamente lo que se puede esperar de 9 populares LLMs en Ollama en una RTX 4080.