Tworzenie GraphQL BFF z użyciem Apollo Server

Optymalizuj API前端 z użyciem GraphQL BFF i Apollo Server

Wzorzec Backend for Frontend (BFF) w połączeniu z GraphQL i Apollo Server tworzy potężną architekturę dla nowoczesnych aplikacji webowych.

Optymalizuj API前端 z użyciem GraphQL BFF i Apollo Server

Wzorzec Backend for Frontend (BFF) w połączeniu z GraphQL i Apollo Server tworzy potężną architekturę dla nowoczesnych aplikacji webowych.

Zarządzaj swoimi danymi za pomocą samodzielnie hostowanego magazynu Nextcloud

Nextcloud to lider otwartego źródła, samodzielnie hostowanego rozwiązania do przechowywania i współpracy w chmurze, które daje Ci pełną kontrolę nad swoimi danymi.

dwa potężne systemy zarządzania wiedzą

Wybór odpowiedniego narzędzia do Zarządzania Wiedzą Osobistą (PKM) może znacząco wpłynąć na Twoją wydajność, naukę i organizację informacji. Spójrzmy na Obsidian i LogSeq.

Twoje zdjęcia w samodzielnej, AI-opartej kopii zapasowej

Immich to rewolucyjne, open-source, samozostawiające się rozwiązanie do zarządzania zdjęciami i filmami, które daje Ci pełną kontrolę nad swoimi wspomnieniami. Dzięki funkcjom równorzędnym Google Photos, w tym AI-powered rozpoznawaniu twarzy, inteligentnemu wyszukiwaniu i automatycznemu backupowi z telefonu, wszystko to, przy jednoczesnym zachowaniu prywatności i bezpieczeństwa danych na Twoim własnym serwerze.

Polecenia Elasticsearch do wyszukiwania, indeksowania i analizy

Elasticsearch to potężny rozproszony silnik wyszukiwania i analizy danych oparty na Apache Lucene. Ta kompletna lista poleceń obejmuje istotne polecenia, najlepsze praktyki oraz szybkie odniesienia do pracy z klastrami Elasticsearch.

Wyniki testów GPT-OSS 120b na trzech platformach AI

Testowanie w Pythonie z użyciem pytest, TDD, mockowanie i pokrycie kodu

Testowanie jednostkowe zapewnia, że Twoja kod w Pythonie działa poprawnie i nadal działa, gdy projekt ewoluuje. Ten kompleksowy przewodnik pokrывает wszystko, co musisz wiedzieć na temat testowania jednostkowego w Pythonie, od podstawowych pojęć po zaawansowane techniki.

Tworzenie serwerów MCP dla asystentów AI z przykładami w Pythonie

Protokół Kontekstu Modelu (MCP) rewolucjonizuje sposób, w jaki asystenci AI interagują z zewnętrznymi źródłami danych i narzędziami. W tym przewodniku omówimy, jak zbudować serwery MCP w Pythonie, z przykładami skupionymi na możliwościach wyszukiwania w sieci i skrapowania.

Skróty klawiaturowe Ubuntu -> Twoja wydajność

Skróty klawiaturowe w Ubuntu to istotne narzędzia do maksymalizacji wydajności i efektywności. Niezależnie od tego, czy jesteś programistą, administratorzem systemu, czy zaawansowanym użytkownikiem, te skróty mogą przyspieszyć Twoją pracę i zmniejszyć zależność od myszy.

Python do konwersji HTML na czysty, gotowy do użycia przez LLM Markdown

Konwersja HTML na Markdown to podstawowe zadanie w współczesnych przepływach pracy programistycznych, szczególnie przygotowując treści internetowe do Large Language Models (LLM), systemów dokumentacji lub generatorów stron statycznych takich jak Hugo.

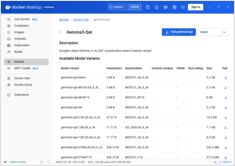

Szybki przewodnik po poleceniach Docker Model Runner

Docker Model Runner (DMR) to oficjalne rozwiązanie firmy Docker do uruchamiania modeli AI lokalnie, wprowadzone w kwietniu 2025 roku. Ten cheatsheet zawiera szybki przewodnik po wszystkich istotnych komendach, konfiguracjach i najlepszych praktykach.

Porównaj Docker Model Runner i Ollama dla lokalnego LLM

Uruchamianie dużych modeli językowych (LLM) lokalnie staje się coraz bardziej popularne ze względu na prywatność, kontrolę kosztów i możliwości offline. Landscape zmienił się znacząco w kwietniu 2025 roku, gdy Docker wprowadził Docker Model Runner (DMR), oficjalne rozwiązanie do wdrażania modeli AI.

Wdrożenie gotowego do produkcji sieci usług - Istio vs Linkerd

Odkryj, jak zaimplementować i zoptymalizować architektury sieci usług przy użyciu Istio i Linkerd. Niniejszy przewodnik obejmuje strategie wdrażania, porównania wydajności, konfiguracje bezpieczeństwa oraz najlepsze praktyki dla środowisk produkcyjnych.

Prosta obsługa maszyn wirtualnych dla Linuxa z GNOME Boxes

W obecnej sytuacji informatycznej wirtualizacja stała się nieodzowna dla rozwoju, testowania i uruchamiania wielu systemów operacyjnych. Dla użytkowników systemu Linux poszukujących prostego i intuicyjnego sposobu zarządzania maszynami wirtualnymi, GNOME Boxes wyróżnia się jako lekki i przyjazny dla użytkownika wybór, który priorytetyzuje łatwość użycia bez poświęcania funkcjonalności.

Protokół społecznościowy decentralizowany z ponad 21K użytkownikami zmieniający prywatność online

Oto Nostr – decentralizowany protokół społecznościowy, który wyzwala dominację dużych firm technologicznych poprzez komunikację odporną na cenzurę i dane kontrolowane przez użytkownika.

Zainstalowanie i konfiguracja wieloprzejściowa oraz podstawowe polecenia

Multipass to lekki menedżer maszyn wirtualnych, który ułatwia tworzenie i zarządzanie instancjami chmurowymi Ubuntu na systemach Linux, Windows i macOS.