LLM ASICの台頭:推論ハードウェアがなぜ重要なのか

専用チップにより、AIの推論がより高速かつ低コストになってきている。

専用チップにより、AIの推論がより高速かつ低コストになってきている。

コンテンツを所有し、アイデンティティをコントロールしましょう

ウェブはもともと、誰でも公開し、接続できる分散型ネットワークとして設計されていました。しかし、時間が経つにつれて、企業のプラットフォームが権限を集中させ、ユーザーが製品となり、コンテンツがロックインされるウォールド・ガーデンを作り出しました。Indie Web movementは、ウェブの元々の約束を復活させることを目指しています:個人所有、創造の自由、そして本物のつながり。

在庫状況、6か国の実際の小売価格、およびMac Studioとの比較。

NVIDIA DGX Spark は現実のものであり、2025年10月15日に販売開始され、CUDA開発者向けに、統合されたNVIDIA AIスタックを使用してローカルLLM作業を行う必要がある人を対象としています。US MSRPは**$3,999**; UK/DE/JPの小売価格はVATとチャネルの影響で高くなっています。AUD/KRWの公開価格はまだ広く掲載されていません。

ジェミニ - ネットワークの軽量で安全な代替手段

Geminiプロトコルは、インターネット通信の基本に立ち返ったものです。複雑化する現代のウェブに代わる、軽量で安全でプライバシーを尊重する代替手段です。

OllamaをGoで統合する: SDKガイド、例、およびプロダクションでのベストプラクティス

このガイドでは、利用可能な Go SDK for Ollama の包括的な概要を提供し、それらの機能セットを比較します。

これらの2つのモデルの速度、パラメータ、パフォーマンスの比較

ここに Qwen3:30b と GPT-OSS:20b の比較を示します。インストラクションに従う能力とパフォーマンスパラメータ、仕様、速度に焦点を当てています:

ホスティングコストの概算とサブスクリプションの比較。

以下は、提供されたHugoページコンテンツの日本語への翻訳です。すべてのHugoショートコード、技術要素、構造を維持しつつ、日本語の文法、文体、表記規則に従って翻訳を行いました。

Write.as / WriteFreelyに関する簡単な情報 – どのようにfediverseに適合するか、管理ホスティングの入手先、使用傾向、およびセルフホスト方法(コストの概算も含む)について。

+ 思考型LLMを使用した具体的な例

この投稿では、PythonアプリケーションをOllamaに接続する方法について2つの方法を紹介します。1つ目はHTTP REST APIを介して、2つ目は公式のOllama Pythonライブラリを介して行います。

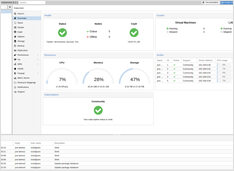

プロクシマックスとは何か?

Proxmox Virtual Environment (Proxmox VE) は、Debian 上に構築されたオープンソースのタイプ1ハイパバーリザーバーおよびデータセンターのオーケストレーションプラットフォームです。

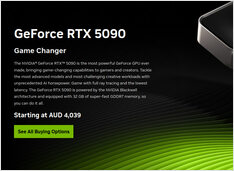

AIに最適な消費者向けGPUの価格 - RTX 5080およびRTX 5090

またまた、LLM(大規模言語モデル)に特に、AI全般に適した上位レベルの消費者向けGPUの価格を比較してみましょう。具体的には、以下を確認しています。

RTX-5080およびRTX-5090の価格

価格はわずかに下がっています。

あまり良くない。

OllamaのGPT-OSSモデルは、特にLangChainやOpenAI SDK、vllmなどのフレームワークと併用する際、構造化された出力の処理に繰り返し問題を抱えています。

Ollamaから構造化された出力を得るいくつかの方法

大規模言語モデル(LLM) は強力ですが、実運用では自由な形式の段落はほとんど使いません。 代わりに、予測可能なデータ:属性、事実、またはアプリにフィードできる構造化されたオブジェクトを望みます。 それはLLM構造化出力です。

Kubuntu と KDE Neon の両方を試してみたが、Kubuntu のほうがより安定している。

KDE Plasmaファンにとって、2つのLinuxディストリビューションがよく議論の対象になります:

Kubuntu と KDE Neon。

どちらも似ているように見えるかもしれません。どちらもKDE Plasmaをデフォルトのデスクトップとして搭載し、どちらもUbuntuをベースにし、どちらも新規ユーザーに親しみやすいです。

オラマモデルのスケジューリングに関する自分のテスト ````

ここでは、新しいバージョンのOllamaがモデルに対してどのくらいのVRAMを割り当てているかについて、Ollama VRAM割り当てと以前のOllamaバージョンを比較しています。新しいバージョンは、実際には以前のバージョンよりも劣っています。

Linuxで静的IPを設定する際の注意点

このガイドでは、Ubuntu サーバーでの静的IPアドレスの変更の手順をステップバイステップで説明します。

現在のOllama開発状況に対する私の見解

Ollama は、LLMをローカルで実行するためのツールとして非常に人気を博しています。

シンプルなCLIとスムーズなモデル管理により、クラウド外でAIモデルに取り組む開発者にとっての定番オプションとなっています。

しかし、多くの有望なプラットフォームと同様に、すでに Enshittification の兆候が見られるようになってきています。