ローカルLLMホスティング:2026年完全ガイド - Ollama、vLLM、LocalAI、Jan、LM Studio など

12種類以上のツールを使ってローカルLLMの展開をマスターする

ローカルでのLLMの展開は、開発者や組織がプライバシーを高め、レイテンシーを減らし、AIインフラストラクチャの制御を強化するための手段として、ますます人気になってきています。

12種類以上のツールを使ってローカルLLMの展開をマスターする

ローカルでのLLMの展開は、開発者や組織がプライバシーを高め、レイテンシーを減らし、AIインフラストラクチャの制御を強化するための手段として、ますます人気になってきています。

Goマイクロサービスを使用して堅牢なAI/MLパイプラインを構築しましょう

AIおよび機械学習(ML)ワークロードがますます複雑になるにつれて、強固なオーケストレーションシステムの必要性が高まっています。Goのシンプルさ、パフォーマンス、並行処理能力は、MLパイプラインのオーケストレーションレイヤーを構築する際に理想的な選択肢です。モデル自体がPythonで書かれている場合でも、Goは理想的な選択肢です。https://www.glukhov.org/ja/post/2025/11/go-microservices-for-ai-ml-orchestration-patterns/ “Go in ML orchestration pipelines”。

テキスト、画像、音声を共有された埋め込み空間に統一する

クロスモーダル埋め込みは、人工知能において画期的な進展をもたらし、統一された表現空間内で異なるデータタイプ間の理解と推論を可能にします。

予算のハードウェアでオープンモデルを使用して企業向けAIを展開

AIの民主化はここにあります。 Llama 3、Mixtral、QwenなどのオープンソースLLMが、今やプロプライエタリモデルと同等の性能を発揮するようになり、チームは消費者ハードウェアを使用して強力なAIインフラストラクチャを構築できるようになりました。これにより、コストを削減しながらも、データプライバシーやデプロイメントに関する完全なコントロールを維持することが可能です。

LongRAG、Self-RAG、GraphRAG - 次世代の技術

リトリーバル・オーガナイズド・ジェネレーション (RAG) は単純なベクトル類似性検索を超えています。 LongRAG、Self-RAG、GraphRAGはこれらの能力の最先端を代表しています。

データサイエンス作業用のLinux環境構築をマスターする

Linuxは、データサイエンス専門家にとって事実上のオペレーティングシステムとなり、類い稀な柔軟性、パフォーマンス、豊富なツールエコシステムを提供しています。

GGUF量子化でFLUX.1-devを高速化

FLUX.1-dev は、驚くほど美しい画像を生成できる強力なテキストから画像生成モデルですが、24GB以上のメモリが必要なため、多くのシステムでは実行が難しいです。 GGUF量化されたFLUX.1-dev は、メモリ使用量を約50%削減しながらも、優れた画像品質を維持するという解決策を提供します。

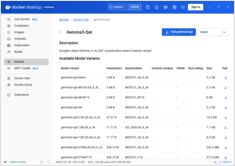

Docker Model Runnerでコンテキストサイズを設定する方法と回避策

ドッカー・モデル・ランナーでのコンテキストサイズの設定は、本来よりも複雑です。

テキスト指示を使って画像を拡張するためのAIモデル

ブラックフォレスト・ラボズは、FLUX.1-Kontext-devという高度な画像から画像へのAIモデルをリリースしました。このモデルは、テキストの指示を使って既存の画像を補強します。

NVIDIA CUDAをサポートするDocker Model RunnerでGPU加速を有効にする

Docker Model Runner は、AIモデルをローカルで実行するためのDocker公式ツールですが、NVIDIA GPU加速をDocker Model Runnerで有効にする には特定の設定が必要です。

LLMのコストを80%削減するスマートなトークン最適化で

トークン最適化は、コスト効率の良いLLMアプリケーションから予算を圧迫する実験を分ける重要なスキルです。

GPT-OSS 120bの3つのAIプラットフォームでのベンチマーク

Pythonの例を使ってAIアシスタント用のMCPサーバーを構築する

モデルコンテキストプロトコル(MCP)は、AIアシスタントが外部データソースやツールとどのように相互作用するかを革命的に変えてきました。本ガイドでは、ウェブ検索およびスクレイピング機能に焦点を当てた例を用いて、MCPサーバーをPythonで構築する方法について説明します。

Docker Model Runner コマンドのクイックリファレンス

Docker Model Runner (DMR) は、2025年4月に導入されたDocker公式のAIモデルをローカルで実行するためのソリューションです。このチートシートは、すべての必須コマンド、設定、ベストプラクティスのクイックリファレンスを提供しています。

Docker Model RunnerとOllamaを用いたローカルLLMの比較

ローカルで大規模言語モデル(LLM)を実行する は、プライバシー、コスト管理、オフライン機能のため、ますます人気になっています。 2025年4月にDockerがDocker Model Runner(DMR)、AIモデルの展開用公式ソリューションを導入したことで、状況は大きく変わりました。

専用チップにより、AIの推論がより高速かつ低コストになってきている。