Costruire un BFF GraphQL con Apollo Server

Ottimizza le API frontend con GraphQL BFF e Apollo Server

Il modello Backend for Frontend (BFF) combinato con GraphQL e Apollo Server crea un’architettura potente per le moderne applicazioni web.

Ottimizza le API frontend con GraphQL BFF e Apollo Server

Il modello Backend for Frontend (BFF) combinato con GraphQL e Apollo Server crea un’architettura potente per le moderne applicazioni web.

Controlla i tuoi dati con il cloud storage self-hosted Nextcloud

Nextcloud è la piattaforma di archiviazione e collaborazione cloud open source e autoospitata leader che mette completamente sotto il tuo controllo i tuoi dati.

due potenti sistemi di gestione della conoscenza

Scegliere lo strumento giusto per la Gestione Personale della Conoscenza (PKM) può influenzare in modo significativo la tua produttività, l’apprendimento e l’organizzazione delle informazioni. Vediamo insieme Obsidian e LogSeq.

Le tue foto sul backup alimentato da AI autoospitato

Immich è una soluzione rivoluzionaria, open-source e autoospitata per la gestione di foto e video che ti dà il pieno controllo sui tuoi ricordi. Con funzionalità paragonabili a quelle di Google Photos, tra cui il riconoscimento facciale alimentato dall’intelligenza artificiale, la ricerca intelligente e il backup automatico dal telefono, tutto mantenendo i tuoi dati privati e sicuri sul tuo server.

Comandi di Elasticsearch per la ricerca, l'indicizzazione e l'analisi

Elasticsearch è un potente motore di ricerca e analisi distribuito costruito su Apache Lucene. Questo completo riferimento rapido copre comandi essenziali, best practice e riferimenti rapidi per lavorare con i cluster Elasticsearch.

Benchmark GPT-OSS 120b su tre piattaforme AI

Ho trovato alcuni interessanti test di prestazioni su GPT-OSS 120b in esecuzione su Ollama su tre diversi piattaforme: NVIDIA DGX Spark, Mac Studio e RTX 4080. Il modello GPT-OSS 120b della libreria Ollama pesa 65 GB, il che significa che non si adatta alla VRAM da 16 GB di un RTX 4080 (o al più recente RTX 5080).

Test Python con pytest, TDD, mocking e coverage

L’unità di test garantisce che il tuo codice Python funzioni correttamente e continui a funzionare mentre il progetto evolve. Questa guida completa copre tutto ciò che devi sapere sulle unità di test in Python, dagli concetti di base alle tecniche avanzate.

Costruisci server MCP per assistenti AI con esempi in Python

Il Model Context Protocol (MCP) sta rivoluzionando il modo in cui gli assistenti AI interagiscono con le fonti di dati esterne e gli strumenti. In questa guida, esploreremo come costruire server MCP in Python, con esempi focalizzati sulle capacità di ricerca web e scraping.

Scorciatoie da tastiera di Ubuntu -> la tua produttività

Le scorciatoie da tastiera di Ubuntu sono strumenti essenziali per massimizzare la produttività e l’efficienza. Che tu sia uno sviluppatore, un sysadmin o un utente avanzato, queste scorciatoie potrebbero accelerare il tuo flusso di lavoro e ridurre la dipendenza dal mouse.

Python per convertire HTML in Markdown pulito e pronto per l'LLM

Conversione da HTML a Markdown è un compito fondamentale nei flussi di lavoro moderni di sviluppo, in particolare quando si prepara il contenuto web per i Large Language Models (LLMs), i sistemi di documentazione o i generatori di siti statici come Hugo.

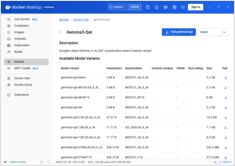

Riferimento rapido per i comandi di Docker Model Runner

Docker Model Runner (DMR) è la soluzione ufficiale di Docker per eseguire modelli AI localmente, introdotta ad aprile 2025. Questa guida rapida fornisce un riferimento veloce per tutti i comandi essenziali, le configurazioni e le best practice.

Confronta Docker Model Runner e Ollama per LLM locali

Running large language models (LLMs) locally ha guadagnato popolarità per la privacy, il controllo dei costi e le capacità offline. Il panorama è cambiato significativamente ad aprile 2025 quando Docker ha introdotto Docker Model Runner (DMR), la sua soluzione ufficiale per il deployment dei modelli AI.

Distribuisci un service mesh pronto per la produzione - Istio vs Linkerd

Scopri come implementare e ottimizzare le architetture di service mesh utilizzando Istio e Linkerd. Questa guida copre strategie di deployment, confronti di prestazioni, configurazioni di sicurezza e best practice per ambienti di produzione.

Gestione semplice di VM per Linux con GNOME Boxes

Nel panorama attuale dell’informatica, la virtualizzazione è diventata essenziale per lo sviluppo, i test e l’esecuzione di diversi sistemi operativi. Per gli utenti Linux che cercano un modo semplice e intuitivo per gestire le macchine virtuali, GNOME Boxes si distingue come un’opzione leggera e user-friendly che privilegia l’usabilità senza sacrificare le funzionalità.

Protocollo sociale decentralizzato con oltre 21K utenti che sta riformando la privacy online

Ecco qui Nostr - il protocollo sociale decentralizzato che sta sfidando la dominanza del Big Tech con comunicazioni resistenti alla censura e dati controllati dagli utenti.

Installazione multipass, configurazione e comandi essenziali

Multipass è un gestore leggero di macchine virtuali che rende semplice la creazione e la gestione di istanze cloud Ubuntu su Linux, Windows e macOS.