Problemas de salida estructurada de Ollama GPT-OSS

No muy agradable.

Los modelos GPT-OSS de Ollama tienen problemas recurrentes al manejar salidas estructuradas, especialmente cuando se usan con marcos como LangChain, OpenAI SDK, vllm y otros.

No muy agradable.

Los modelos GPT-OSS de Ollama tienen problemas recurrentes al manejar salidas estructuradas, especialmente cuando se usan con marcos como LangChain, OpenAI SDK, vllm y otros.

Un par de formas de obtener salida estructurada de Ollama

Modelos de Lenguaje Grande (LLMs) son poderosos, pero en producción raramente queremos párrafos libres. En su lugar, queremos datos predecibles: atributos, hechos u objetos estructurados que puedas alimentar en una aplicación. Eso es Salida Estructurada de LLM.

Mi propia prueba de programación del modelo ollama ```

Aquí estoy comparando cuánta VRAM asigna la nueva versión de Ollama al modelo con la versión anterior de Ollama. La nueva versión es peor.

Mi opinión sobre el estado actual del desarrollo de Ollama

Ollama ha pasado rápidamente a ser una de las herramientas más populares para ejecutar LLMs localmente.

Su CLI simple y su gestión de modelos optimizada han hecho que sea una opción favorita para desarrolladores que desean trabajar con modelos de IA fuera de la nube.

Pero, al igual que con muchas plataformas prometedoras, ya hay señales de Enshittification:

Breve visión general de las interfaces de usuario más destacadas para Ollama en 2025

Locally hosted Ollama permite ejecutar modelos de lenguaje grandes en tu propia máquina, pero usarlo desde la línea de comandos no es muy amigable para el usuario. Aquí hay varios proyectos de código abierto que ofrecen interfaces estilo ChatGPT que se conectan a un Ollama local.

Implementando RAG? Aquí hay algunos fragmentos de código en Go - 2...

Dado que el Ollama estándar no tiene una API de rerank directa, tendrás que implementar reranking usando Qwen3 Reranker en GO generando embeddings para pares de consulta y documentos y calificándolos.

qwen3 8b, 14b y 30b, devstral 24b, mistral small 24b

En este test estoy comparando cómo diferentes LLMs alojados en Ollama traducen una página Hugo del inglés al alemán. Tres páginas que probé estaban sobre temas diferentes, tenían algún buen markdown con cierta estructura: encabezados, listas, tablas, enlaces, etc.

Implementando RAG? Aquí hay algunos fragmentos de código en Golang...

Este pequeño Ejemplo de código Go para reranking llama a Ollama para generar embeddings para la consulta y para cada documento candidato, luego ordenando de forma descendente por similitud coseno.

Nuevos modelos LLM impresionantes disponibles en Ollama

Los modelos de incrustación y reordenamiento de Qwen3 son las últimas versiones lanzadas en la familia Qwen, especialmente diseñados para tareas avanzadas de incrustación de texto, recuperación y reordenamiento.

¿Piensa en instalar una segunda GPU para LLMs?

Cómo afectan los canales PCIe al rendimiento de los LLM? Dependiendo de la tarea. Para el entrenamiento y la inferencia con múltiples GPUs, la caída de rendimiento es significativa.

LLM para extraer texto de HTML...

En la biblioteca de modelos de Ollama hay modelos que pueden convertir contenido HTML a Markdown, lo cual es útil para tareas de conversión de contenido.

Cursor AI vs GitHub Copilot vs Cline AI vs...

Listaré aquí algunas herramientas de codificación asistidas por IA y Asistentes de codificación de IA y sus aspectos positivos.

Ollama en CPU de Intel: núcleos eficientes vs. núcleos de rendimiento

Tengo una teoría para probar: ¿si utilizamos todos los núcleos en una CPU de Intel aumentaría la velocidad de los LLMs? Me molesta que el nuevo modelo gemma3 de 27 bits (gemma3:27b, 17 GB en ollama) no se ajuste a los 16 GB de VRAM de mi GPU, y se ejecute parcialmente en la CPU.

Configurando ollama para la ejecución de solicitudes en paralelo.

Cuando el servidor Ollama recibe dos solicitudes al mismo tiempo, su comportamiento depende de su configuración y de los recursos del sistema disponibles.

Comparando dos modelos deepseek-r1 con dos modelos base

El primer generación de modelos de razonamiento de DeepSeek con un rendimiento comparable al de OpenAI-o1, incluyendo seis modelos densos destilados de DeepSeek-R1 basados en Llama y Qwen.

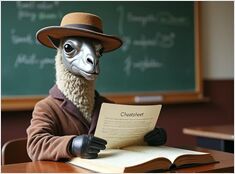

Compilé esta lista de comandos de Ollama hace algún tiempo...

Aquí está la lista y ejemplos de los comandos más útiles de Ollama (cheat sheet de comandos de Ollama) La compilé hace algún tiempo, actualizado por última vez en enero de 2026. Espero que también sea útil para usted.