Farfalle vs. Perplexica

Comparando dos motores de búsqueda de IA autohospedados

La comida deliciosa también es un placer para los ojos.

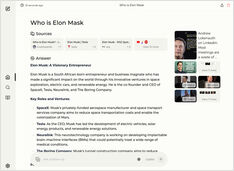

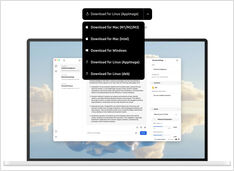

Pero en este post compararemos dos sistemas de búsqueda basados en IA, Farfalle y Perplexica.

Comparando dos motores de búsqueda de IA autohospedados

La comida deliciosa también es un placer para los ojos.

Pero en este post compararemos dos sistemas de búsqueda basados en IA, Farfalle y Perplexica.

¿Ejecutando un servicio estilo copilot localmente? ¡Fácil!

¡Eso es muy emocionante! En lugar de llamar a copilot o perplexity.ai y contarle al mundo entero qué es lo que buscas, ahora puedes alojar un servicio similar en tu propio PC o laptop.

No hay tantas opciones, pero aún así...

Cuando empecé a experimentar con LLMs, las interfaces de usuario para ellos estaban en desarrollo activo y ahora algunas de ellas son realmente buenas.

Prueba de detección de falacias lógicas

Recientemente hemos visto la liberación de varios nuevos LLMs. Tiempo emocionante. Vamos a probar y ver cómo se desempeñan al detectar falacias lógicas.

Requiere algún experimento pero

Aún así, existen algunos enfoques comunes para escribir buenos prompts de manera que los modelos de lenguaje no se confundan al intentar entender lo que deseas.

Fragmentos de código de Python frecuentemente necesarios

A veces necesito esto pero no puedo encontrarlo inmediatamente.

Así que los mantengo todos aquí.

Etiquetar y entrenar necesita algo de pegamento

Cuando entrené un detector de objetos AI hace algún tiempo - LabelImg fue una herramienta muy útil, pero la exportación desde Label Studio a formato COCO no era aceptada por el marco MMDetection..

8 versiones de llama3 (Meta+) y 5 versiones de phi3 (Microsoft) LLM

Probando cómo se comportan los modelos con diferentes números de parámetros y cuantización.

Los archivos del modelo LLM de Ollama ocupan mucho espacio.

Después de instalar ollama, es mejor reconfigurar ollama para que los almacene en un nuevo lugar de inmediato. Así, después de que descarguemos un nuevo modelo, no se descargará en el lugar antiguo.

Probemos la velocidad de los LLM en GPU frente a CPU

Comparando la velocidad de predicción de varias versiones de LLMs: llama3 (Meta/Facebook), phi3 (Microsoft), gemma (Google), mistral (open source) en CPU y GPU.

Probemos la calidad de detección de falacias lógicas de diferentes LLMs

Aquí estoy comparando varias versiones de LLM: Llama3 (Meta), Phi3 (Microsoft), Gemma (Google), Mistral Nemo (Mistral AI) y Qwen (Alibaba).