Przenieś modele Ollama do innego miejsca

Pliki modeli LLM Ollama zajmują dużo miejsca.

Po zainstalowaniu ollama lepiej jest natychmiast skonfigurować Ollama, aby przechowywać je w nowym miejscu. Wtedy, gdy pobieramy nowy model, nie zostaje on pobrany do starego lokalizacji.

O Ollama

Ollama to interfejs tekstowy do modeli AI LLM oraz API, które może je również hostować.

Instalacja Ollama

Przejdź na stronę https://ollama.com/download

Aby zainstalować Ollama na systemie Linux:

curl -fsSL https://ollama.com/install.sh | sh

Ollama na Windows znajduje się na stronie: https://ollama.com/download/windows Ollama dla Mac również znajduje się tam: https://ollama.com/download/macOllamaSetup.exe

Pobieranie, listowanie i usuwanie modeli Ollama

Aby pobrać modele Ollama: Przejdź do biblioteki Ollama (https://ollama.com/library) i znajdź model, którego potrzebujesz, tam również znajdziesz tagi modeli i ich rozmiary.

Następnie uruchom:

ollama pull gemma2:latest

# Lub pobierz nieco bardziej zaawansowany model, który nadal dobrze mieści się w 16 GB VRAM:

ollama pull gemma2:27b-instruct-q3_K_S

# Lub:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

Aby sprawdzić modele, które Ollama ma w lokalnej repozytorium:

ollama list

Aby usunąć niepotrzebny model:

ollama rm qwen2:7b-instruct-q8_0 # na przykład

Lokalizacja modeli Ollama

Domyślnie pliki modeli są przechowywane:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

Konfigurowanie ścieżki modeli Ollama na Windows

Aby utworzyć zmienną środowiskową na Windows, możesz postępować zgodnie z poniższymi instrukcjami:

- Otwórz ustawienia Windows.

- Przejdź do System.

- Wybierz Opcje.

- Wybierz Zaawansowane ustawienia systemowe.

- Przejdź na kartę Zaawansowane.

- Wybierz Zmienne środowiskowe.

- Kliknij Nowy.

- Utwórz zmienną o nazwie OLLAMA_MODELS wskazującą na miejsce, w którym chcesz przechowywać modele

Przenoszenie modeli Ollama na Linux

Edytuj parametry usługi systemd Ollama

sudo systemctl edit ollama.service

lub

sudo xed /etc/systemd/system/ollama.service

To otworzy edytor.

Dla każdej zmiennej środowiskowej dodaj linię Environment w sekcji [Service]:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

Zapisz i wyjdź.

Istnieją również parametry User i Group, które muszą mieć dostęp do tego folderu.

Przeładuj systemd i uruchom ponownie Ollama:

sudo systemctl daemon-reload

sudo systemctl restart ollama

jeśli coś poszło nie tak

systemctl status ollama.service

sudo journalctl -u ollama.service

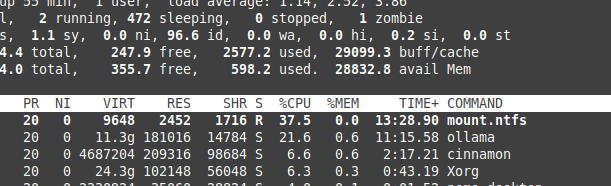

Przechowywanie plików na partycji NTFS

Proszę zwrócić uwagę, że jeśli uruchamiasz system Linux i przechowujesz swoje modele na partycji sformatowanej jako NTFS, twoje modele będą ładować się znacznie wolniej – więcej niż o 20%.

Instalacja Ollama na Windows w określonym folderze

Razem z modelami

.\OllamaSetup.exe /DIR=D:\OllamaDir

Wyświetlanie API Ollama w sieci lokalnej

Lokalna sieć oznacza sieć lokalną.

Dodaj do konfiguracji usługi:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Przydatne linki

- Test: Jak Ollama wykorzystuje wydajność i efektywne jądra procesora Intel

- Jak Ollama obsługuje żądania równoległe

- Testowanie modelu Deepseek-r1 na Ollama

- Wydajność LLM i linie PCIe: kluczowe rozważania

- Wykrywanie błędów logicznych za pomocą LLM

- Porównanie wydajności LLM

- Porównanie zdolności LLM do tworzenia streszczeń

- Pisanie skutecznych promptów dla LLM

- Samohostowanie Perplexica – z użyciem Ollama

- Karta pamięci Conda

- Karta pamięci Docker

- Dostawcy LLM w chmurze

- Modele Qwen3 Embedding & Reranker na Ollama: wydajność stanu sztuki