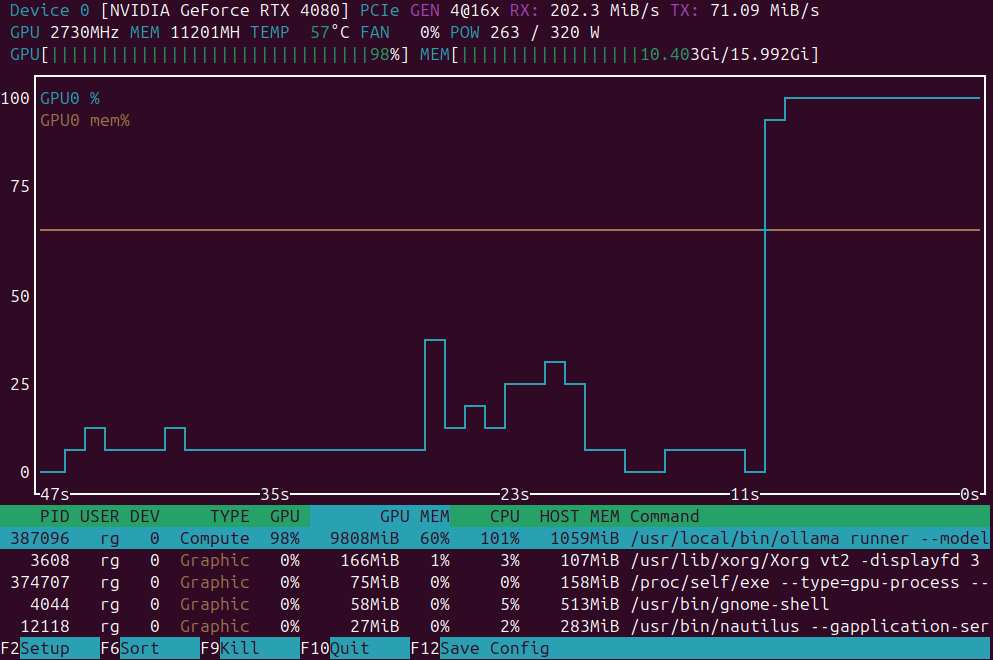

Beste LLMs voor Ollama op een GPU met 16GB VRAM

LLM-snelheidstest op RTX 4080 met 16 GB VRAM

De lokale uitvoering van grote taalmodellen biedt privacy, offline mogelijkheden en nul API-kosten. Deze benchmark toont precies aan wat men kan verwachten van 9 populaire LLMs op Ollama op een RTX 4080.