ファルファッレ vs パーペクシカ

2つのセルフホスト型AI検索エンジンの比較

美味しい料理は目にも楽しめます。 しかし、本記事ではAIに基づく2つの検索システム、FarfalleとPerplexicaを比較します。

ちなみに、このパスタの形も「farfalle」と呼ばれます。

しかし、ここではこの2つのシステムの動作方法についてのみ比較しています。パスタの形についてはここでは触れません。

OK。集中しましょう!

ご参照ください Perplexicaのインストールと設定 - Ollamaを使用 および Ollamaのインストールと設定。

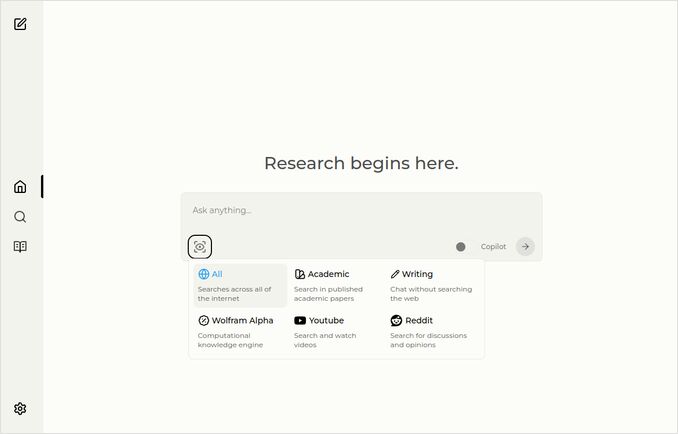

Perplexica

ここにソース選択ドロップダウン付きのホームページがあります。

- Perplexicaは以下で実装されています

- TypeScriptとReact.Js(UI)

- TypeScriptとExpress.Js(バックエンド)

- SearxNGメタ検索エンジンの設定も含まれています

- Copilotモードがあります

- OllamaでホストされているLLMをチャットまたは埋め込みモデルとして使用できる機能があります

- 3つの小さな内部埋め込みモデルがあります

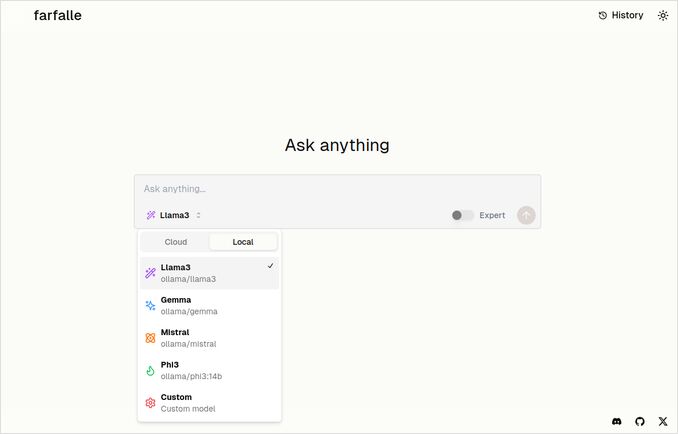

Farfalle

- Farfalleは以下で実装されています

- TypeScriptとReact.Js(UI)

- Python Fastapi(バックエンド)

- SearxNGメタ検索エンジンのリファレンスも含まれていますが、設定はあまり多くありません。標準的なDockerイメージです。

- Expertモードがあり、元の質問からいくつかのリクエストを準備し、応答を組み合わせる必要があります。しかし、私たちのテストではこれは動作しませんでした。

- Ollamaでホストされている4つのLLM(llama3、mistral、gemma、phi3)をチャットモデルとして使用できる機能があります。これは良いオプションのセットですが、Ollamaが提供するモデルをすべて使用できるようにもっと柔軟性があると嬉しいです。

- 埋め込みモデルのオプションはありません

PerplexicaとFarfalle自身による比較

同じリクエストを実行しました FarfalleとPerplexicaを堅牢性、コミュニティ、サポート、LLMサポートに基づいて比較してください

両方のPerplexicaとFarfalleは、ローカルのollama上でホストされているllama3モデルを使用しています。 モデルのフルネームはllama3 8b q4です。

応答の内容を100%信じる必要はありません。テキストの長さ、構造、全体的な応答の質を見てください。

約70%は信じるでしょう…

Perplexicaの比較応答

FarfalleとPerplexicaの比較

堅牢性

Farfalle: 8/10 - Farfalleは、複雑なクエリを処理する能力があり、信頼性が高く知られているAI検索エンジンです。自然言語処理(NLP)および機械学習(ML)における強固な基礎があります。完璧ではないかもしれませんが、Farfalleの堅牢性は確立されています。

Perplexica: 9/10 - Perplexicaは、Meta AIのPhi-3モデルに基づいて構築されており、堅牢性が設計されています。曖昧または不明確なクエリに直面しても正確な回答を提供するようにテストされています。質問を再構成し、さまざまなコンテキストに適応する能力により、Perplexicaは堅牢な検索エンジンです。

コミュニティ

Farfalle: 7/10 - Farfalleには、その能力を評価するユーザーの専門的なコミュニティがあります。Perplexicaほど普及していないかもしれませんが、Farfalleのユーザー層は依然として顕著です。

Perplexica: 8.5/10 - Perplexicaは、検索エンジンに対する革新的なアプローチにより広く認知されています。そのコミュニティは急速に成長しており、多くのユーザーが正確で関連性の高い結果を提供することを評価しています。

サポート

Farfalle: 6.5/10 - Farfalleは、FAQ、ドキュメント、フォーラムを通じて基本的なサポートを提供しています。Perplexicaのサポートほど包括的ではありませんが、Farfalleのユーザー層は一般的に自立しています。

Perplexica: 9/10 - Perplexicaは、詳細なドキュメント、FAQ、コミュニティフォーラムを含む豊富なサポートリソースを提供しています。開発者はコミュニティと積極的に関わり、ユーザーがタイムリーで効果的な支援を受けられるようにしています。

サポートされているLLM

Farfalle: なし - Farfalleは、大規模言語モデル(LLM)に依存せず、独自のAI検索エンジンです。

Perplexica: あり - Perplexicaは、Meta AIのPhi-3モデルに基づいて構築されており、これはLLMです。これにより、Perplexicaは深層学習の力を利用してより正確で関連性の高い結果を提供できます。

総合スコア Farfalle: 22/30 Perplexica: 34.5/40

これらの基準に基づくと、Perplexicaは堅牢性、コミュニティサポート、LLM統合においてFarfalleにわずかな優位性があります。しかし、両方の検索エンジンにはそれぞれの強みがあり、最終的な選択はあなたの具体的なニーズと好みに依存します。

推奨:信頼性の高いAI検索エンジンで、強力なNLP能力を求める場合は、Perplexicaがより良い選択肢かもしれません。シンプルで手軽な検索を好む場合は、Farfalleも依然として優れた結果を提供できます。

Farfalleの比較応答

FarfalleとPerplexicaの比較

FarfalleとPerplexicaは、最近注目を集めている2つのAI駆動型検索エンジンです。堅牢性、コミュニティ、サポート、LLM(大規模言語モデル)サポートに基づいてこれらの2つのプロジェクトを比較します。

堅牢性

- Farfalleは、ローカルまたはクラウドLLMを使用してセルフホストされた設計になっており、検索エンジンをコントロールしたいユーザーにとってより堅牢なオプションです。

- 一方、PerplexicaはPerplexity AIのオープンソース代替であり、開発者によって継続的に改善されています。

コミュニティ

- Perplexicaには、その開発とサポートに貢献する開発者とユーザーの専門的なコミュニティがあります。

- Farfalleのコミュニティは規模が小さいですが、GitHub上に存在しています。

サポート

- Perplexicaは定期的なアップデートと改善、および通常のサポート以外の話題について議論するためのDiscordチャネルを提供しています。

- FarfalleのサポートはGitHubのIssueとPull Requestに限定されています。

LLMサポート:FarfalleとPerplexicaの両方ともLLMをサポートしています。PerplexicaはOllama、ローカルLLMを使用していますが、FarfalleはローカルおよびクラウドLLMの両方をサポートしています。

要約すると、セルフホストされた設計によりFarfalleはより堅牢ですが、Perplexicaはコミュニティとサポートがより強力です。両方のプロジェクトはLLMをサポートしていますが、PerplexicaはOllamaを特に使用しています。

結論

PerplexicaとFarfalleの違いは何ですか?

答え:

- いくつかの事実誤りを置き去りにすれば、両システムはPerplexicaがFarfalleより優れていると考えています。私はそれに同意したいです。

- FarfalleのUIは本当に気に入っています。それらはかなり近いですが。

- FarfalleのExpertモードのアイデアは好きですが、私の環境では動作しませんでした。

- Farfalleを実行する際に3つのバグに遭遇しました。Perplexicaのコードはより洗練されています。

- 設定後、Perplexicaはエラーなく実行されました。

- PerplexicaはOllamaでホストされている任意のモデルを使用できます。一方、FarfalleはGemma、Llama3、Mistral、Phi3(少し古くなったプリ定義バージョン)のみを使用できます。

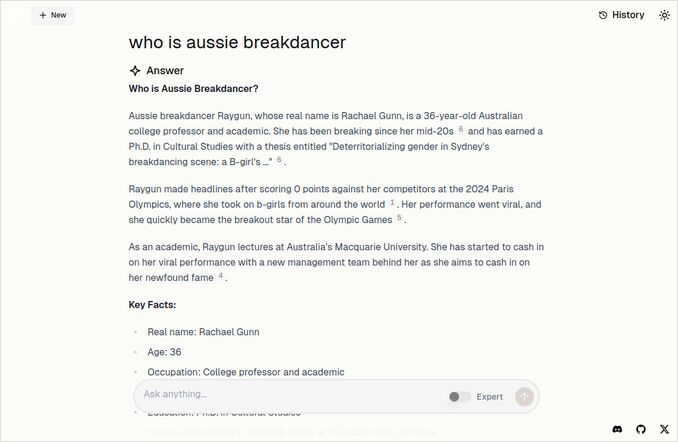

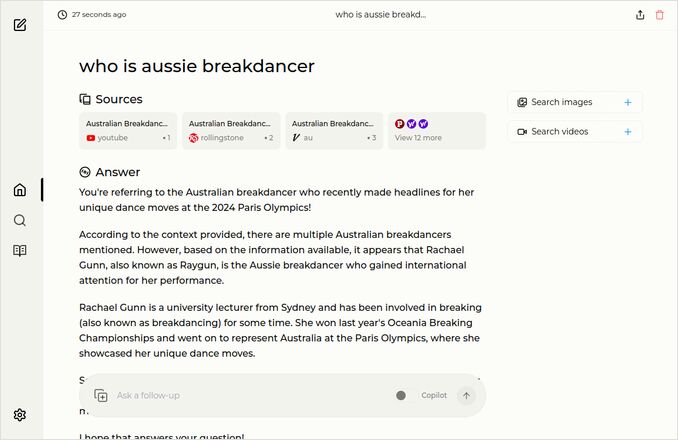

- Farfalleの応答はより好きです。下のFarfalleの画像を見てください。直にポイントに到達し、「Accrording to the context provided」のようなものはありません。

他の例

これらは、オーストラリアのブレイクダンサーに関する同じ質問への応答を示しています。 ご存知のように、博士号を持つ人物で、0(ゼロ)ポイントを獲得し、おそらくオリンピックのプログラムからブレイクダンスが削除された人物です。

Farfalleの応答

Perplexicaの応答

この最後の段落を読む(または下にスクロールする)と、私の興味と同じであることに感謝します。本当にエキサイティングな時代です。 素晴らしい一日を!

有用なリンク

- 検索 vs Deepsearch vs Deep Research

- テスト: OllamaがIntel CPUのパフォーマンスと効率的なコアを使用する方法

- Ollamaが並列リクエストを処理する方法

- Perplexicaのセルフホスティング - Ollamaを使用

- LLMの要約能力の比較

- LLMに効果的なプロンプトの作成

- 新しいLLMによる論理的誤謬検出のテスト: gemma2、qwen2、mistral Nemo

- Ollamaチートシート

- Markdownチートシート

- クラウドLLMプロバイダー

- OllamaやHugging Face、GitHubでのローカルデプロイとQwen3埋め込みおよびリランカーモデル