Farfalle vs Perplexica

Comparaison de deux moteurs de recherche d'IA auto-hébergés

La bonne nourriture est aussi un plaisir pour les yeux. Mais dans cet article, nous allons comparer deux systèmes de recherche basés sur l’IA, Farfalle et Perplexica.

Par ailleurs, cette forme de pâtes est également appelée “farfalle”.

Mais ici, je compare uniquement le comportement de ces deux systèmes et non les formes de pâtes.

OK. Concentrez-vous !

Veuillez également consulter Installation et configuration de Perplexica avec Ollama et Installer et configurer Ollama.

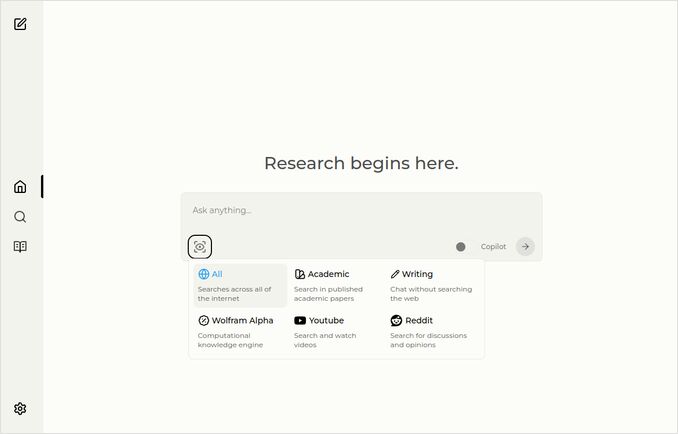

Perplexica

Voici la page d’accueil avec le menu déroulant pour sélectionner les sources.

- Perplexica est implémenté en

- TypeScript et React.Js (interface utilisateur)

- TypeScript et Express.Js (Backend)

- inclut également une configuration pour le moteur de recherche métasearch SearxNG

- Possède un mode Copilot

- Possède la capacité d’utiliser tout modèle LLM hébergé par Ollama en tant que modèle de chat ou de mise en page

- Possède trois petits modèles internes de mise en page

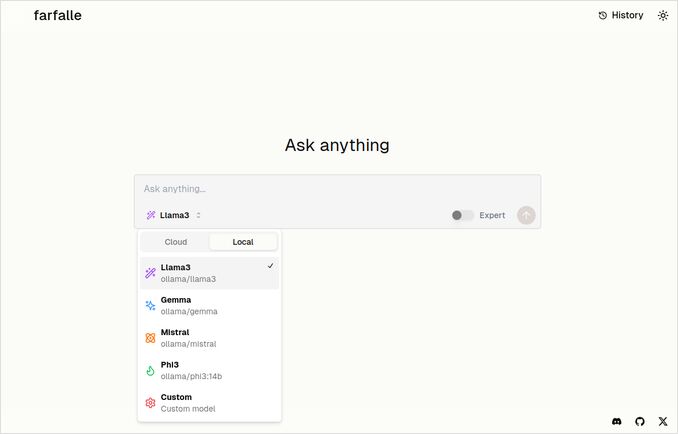

Farfalle

- Farfalle est implémenté en

- TypeScript et React.Js (interface utilisateur)

- Python Fastapi (Backend)

- inclut également une référence au moteur de recherche métasearch SearxNG. Peu de configuration pour cela, une image Docker standard.

- Possède un mode Expert qui devrait préparer plusieurs requêtes à partir de l’originale et combiner les réponses. Mais cela ne fonctionnait pas dans notre test.

- Possède la capacité d’utiliser quatre modèles LLM hébergés par Ollama en tant que modèle de chat (llama3, mistral, gemma, phi3). C’est un bon ensemble d’options, mais je préférerais qu’il soit plus flexible et permette d’utiliser tout modèle que Ollama sert.

- Aucune option pour les modèles de mise en page

Comparaison effectuée par Perplexica et Farfalle eux-mêmes

J’ai exécuté la même requête Comparer farfalle et perplexica sur la base de robustesse, communauté, support et modèles LLM pris en charge

Les deux Perplexica et Farfalle utilisaient le modèle llama3 hébergé localement sur ollama. Le nom complet du modèle est llama3 8b q4.

Ne croyez pas à 100 % ce que disent les réponses, regardez simplement la longueur du texte, la structure et la qualité globale de la réponse.

Je croirais environ 70 %…

Réponse de comparaison de Perplexica

Comparaison entre Farfalle et Perplexica

Robustesse

Farfalle : 8/10 - Farfalle est un moteur de recherche AI populaire connu pour sa fiabilité et sa capacité à gérer des requêtes complexes. Il a une solide base en traitement du langage naturel (NLP) et en apprentissage automatique (ML). Bien qu’il ne soit pas parfait, la robustesse de Farfalle est bien établie.

Perplexica : 9/10 - Perplexica est construit sur le modèle Phi-3 de Meta AI, conçu pour la robustesse. Il a été testé pour fournir des réponses précises même face à des requêtes ambiguës ou peu claires. Sa capacité à reformuler les questions et à s’adapter à différents contextes en fait un moteur de recherche robuste.

Communauté

Farfalle : 7/10 - Farfalle a une communauté dédiée d’utilisateurs qui apprécient ses capacités. Bien qu’il n’ait pas le même niveau d’adoption que Perplexica, la base d’utilisateurs de Farfalle est encore significative.

Perplexica : 8,5/10 - Perplexica a gagné une reconnaissance généralisée pour son approche innovante des moteurs de recherche. Sa communauté croît rapidement, avec de nombreux utilisateurs qui apprécient sa capacité à fournir des résultats précis et pertinents.

Support

Farfalle : 6,5/10 - Farfalle fournit un support de base via des FAQ, de la documentation et des forums. Bien qu’il ne soit pas aussi complet que le support de Perplexica, la communauté d’utilisateurs de Farfalle est généralement autonome.

Perplexica : 9/10 - Perplexica offre des ressources de support extensives, y compris une documentation détaillée, des FAQ et des forums communautaires. Ses développeurs sont activement engagés avec la communauté, assurant aux utilisateurs un assistance timée et efficace.

Modèles LLM pris en charge

Farfalle : Non - Farfalle est un moteur de recherche AI autonome qui ne dépend pas de grands modèles de langage (LLM) pour ses capacités.

Perplexica : Oui - Perplexica est construit sur le modèle Phi-3 de Meta AI, qui est un LLM. Cela permet à Perplexica de tirer parti de la puissance de l’apprentissage profond pour des résultats plus précis et pertinents.

Note globale Farfalle : 22/30 Perplexica : 34,5/40

D’après ces critères, Perplexica semble avoir un léger avantage sur Farfalle en termes de robustesse, de soutien communautaire et d’intégration LLM. Cependant, les deux moteurs de recherche ont leurs propres forces, et le choix dépend finalement de vos besoins et préférences spécifiques.

Recommandation Si vous cherchez un moteur de recherche AI fiable avec des capacités de NLP solides, Perplexica pourrait être le meilleur choix. Si vous préférez une approche plus directe et sans fioritures pour la recherche, Farfalle pourrait tout de même fournir de bons résultats.

Réponse de comparaison de Farfalle

Comparaison entre Farfalle et Perplexica

Farfalle et Perplexica sont deux moteurs de recherche alimentés par l’IA qui ont attiré l’attention récemment. Voici une comparaison de ces deux projets basée sur la robustesse, la communauté, le support et le support LLM (Large Language Model).

Robustesse

- Farfalle est conçu pour être auto-hébergé avec des LLM locaux ou en nuage, ce qui en fait une option plus robuste pour les utilisateurs qui souhaitent contrôler leur moteur de recherche.

- Perplexica, quant à lui, est une alternative open source à Perplexity AI et est constamment améliorée par ses développeurs.

Communauté

- Perplexica a une communauté dédiée de développeurs et d’utilisateurs qui contribuent à son développement et qui fournissent un support

- La communauté de Farfalle est plus petite, mais elle a une présence sur GitHub

Support

- Perplexica propose des mises à jour régulières et des améliorations, ainsi qu’un canal Discord pour discuter de sujets en dehors du support régulier

- Le support de Farfalle est limité aux problèmes GitHub et aux demandes de tirage

Support LLM Les deux Farfalle et Perplexica prennent en charge les LLM. Perplexica utilise Ollama, un LLM local, tandis que Farfalle prend en charge à la fois les LLM locaux et en nuage.

En résumé, Farfalle est plus robuste en raison de sa conception auto-hébergée, tandis que Perplexica a une communauté plus forte et un meilleur support. Les deux projets prennent en charge les LLM, mais Perplexica utilise spécifiquement Ollama.

Conclusion

Quelle est la différence entre Perplexica et Farfalle ?

La réponse :

- En mettant de côté quelques erreurs factuelles, les deux systèmes pensent que Perplexica est meilleur que Farfalle, ce que je suis enclin à accepter.

- J’aime vraiment l’interface utilisateur de Farfalle, bien qu’elles soient assez proches

- J’aime l’idée du mode expert de Farfalle, même si cela ne fonctionnait pas dans mon environnement

- J’ai rencontré 3 bugs lors de l’exécution de Farfalle. Le code de Perplexica est plus poli

- Une fois configuré, Perplexica a fonctionné sans aucun erreur

- Perplexica permet d’utiliser tout modèle hébergé par Ollama. Et Farfalle permet d’utiliser uniquement Gemma, Llama3, Mistral et Phi3 (versions prédéfinies, qui sont un peu obsolètes).

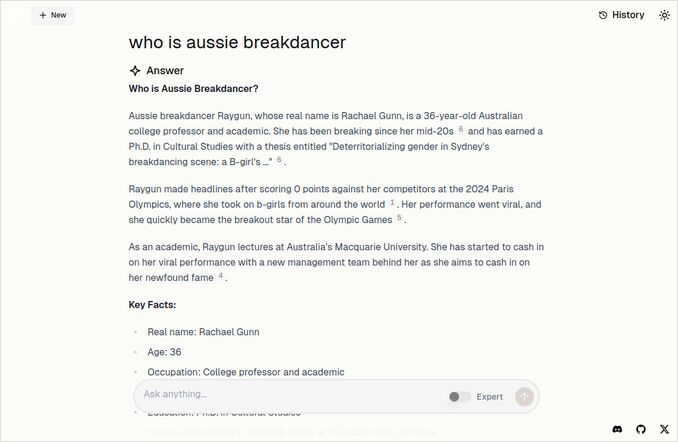

- J’aime plus les réponses de Farfalle. Regardez l’image de Farfalle ci-dessous. Droit au but, sans ces “Selon le contexte fourni”…

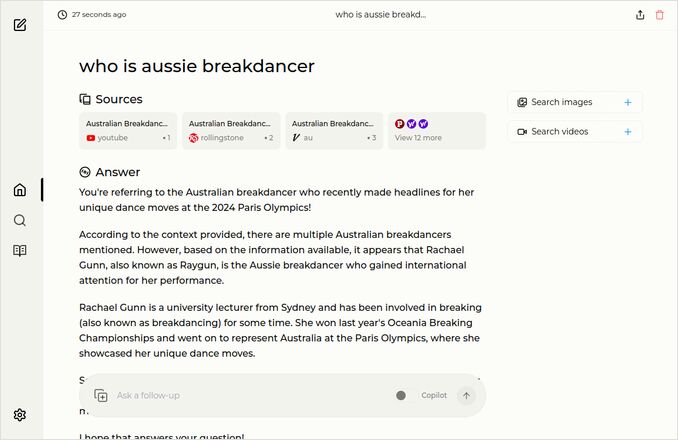

Plus d’exemples

Ces exemples montrent les réponses pour la même question sur le breakdancer australien. Vous savez, celui qui a un doctorat et a obtenu 0 (zéro) points et probablement a eu le breakdancing retiré du programme olympique.

Réponse de Farfalle

Réponse de Perplexica

Si vous lisez (ou descendez) cette dernière paragraphe, merci d’avoir les mêmes centres d’intérêt que moi. C’est vraiment des temps excitants. Bonne journée !

Liens utiles

- Recherche vs Deepsearch vs Deep Research

- Test : Comment Ollama utilise les performances du processeur Intel et les cœurs efficaces

- Comment Ollama gère les requêtes parallèles

- Auto-hébergement de Perplexica - avec Ollama

- Comparaison des capacités de résumé des LLM

- Rédiger des prompts efficaces pour les LLM

- Test de détection des fautes logiques par de nouveaux LLM : gemma2, qwen2 et mistral Nemo

- Feuille de triche d’Ollama

- Feuille de triche Markdown

- Fournisseurs de LLM en nuage

- Modèles Qwen3 d’embedding et de réorganisation sur Ollama : performance d’avant-garde