Modelos de incrustación y reordenación de Qwen3 en Ollama: rendimiento de vanguardia

Nuevos modelos LLM impresionantes disponibles en Ollama

Los modelos de incrustación y reordenamiento de Qwen3 son las últimas versiones lanzadas en la familia Qwen, especialmente diseñados para tareas avanzadas de incrustación de texto, recuperación y reordenamiento.

Alegría para la vista

Los modelos de incrustación y reordenamiento de Qwen3 representan un avance significativo en el procesamiento de lenguaje natural (NLP) multilingüe, ofreciendo un rendimiento de vanguardia en tareas de incrustación y reordenamiento de texto. Estos modelos, parte de la serie Qwen desarrollada por Alibaba, están diseñados para admitir una amplia gama de aplicaciones, desde la recuperación semántica hasta la búsqueda de código. Mientras que Ollama es una plataforma de código abierto popular para alojar y desplegar modelos de lenguaje grandes (LLMs), la integración de los modelos Qwen3 con Ollama no se detalla explícitamente en la documentación oficial. Sin embargo, los modelos están disponibles a través de Hugging Face, GitHub y ModelScope, permitiendo un posible despliegue local mediante Ollama u herramientas similares.

Ejemplos usando estos modelos

Por favor, consulte el código de ejemplo en Go usando ollama con estos modelos:

- Reordenamiento de documentos de texto con Ollama y modelo de incrustación Qwen3 - en Go

- Reordenamiento de documentos de texto con Ollama y modelo de reordenamiento Qwen3 - en Go

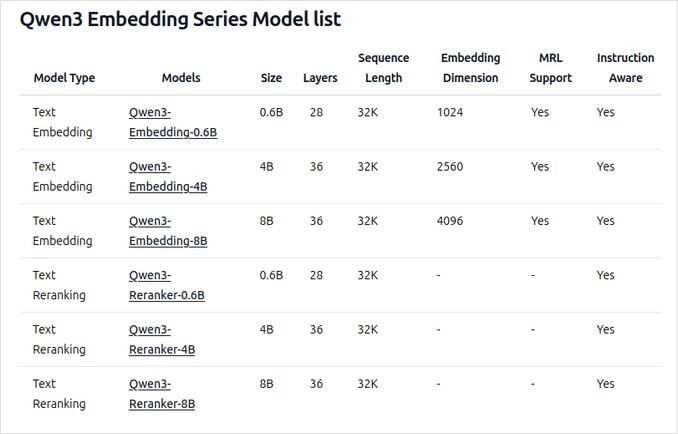

Visión general de los nuevos modelos de incrustación y reordenamiento de Qwen3 en Ollama

Estos modelos ahora están disponibles para su despliegue en Ollama en varios tamaños, ofreciendo un rendimiento de vanguardia y flexibilidad para una amplia gama de aplicaciones relacionadas con el lenguaje y el código.

Funciones y capacidades clave

-

Tamaños del modelo y flexibilidad

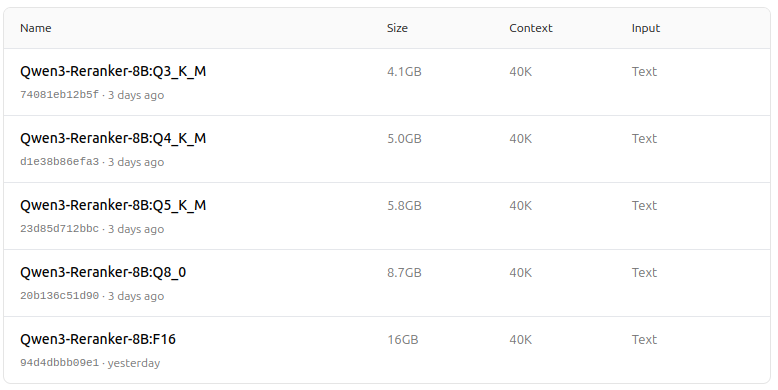

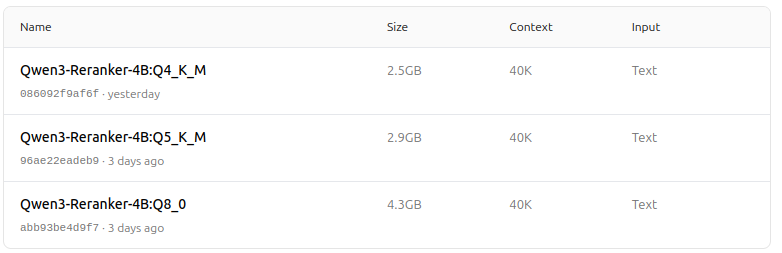

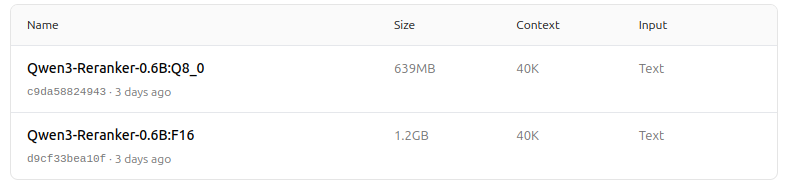

- Disponibles en varios tamaños: 0.6B, 4B y 8B de parámetros para tareas de incrustación y reordenamiento.

- El modelo de incrustación de 8B actualmente ocupa el primer lugar en la tabla de clasificación multilingüe MTEB (hasta el 5 de junio de 2025, con una puntuación de 70.58).

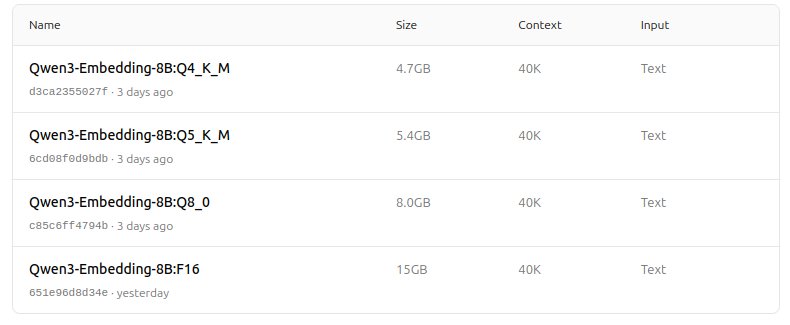

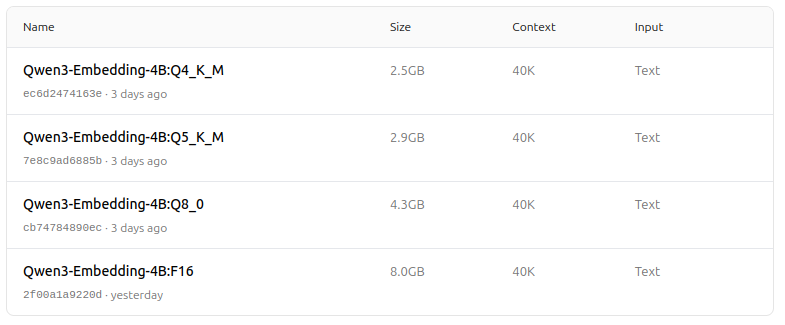

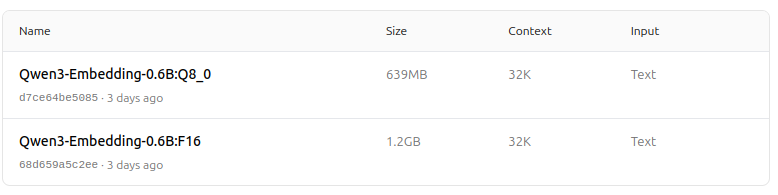

- Soporta una gama de opciones de cuantización (Q4, Q5, Q8, etc.) para equilibrar el rendimiento, el uso de memoria y la velocidad. Q5_K_M se recomienda para la mayoría de los usuarios, ya que preserva la mayor parte del rendimiento del modelo mientras es eficiente en recursos.

-

Arquitectura y entrenamiento

- Construidos sobre la base Qwen3, aprovechando tanto la arquitectura dual-encoder (para incrustaciones) como la arquitectura cross-encoder (para reordenamiento).

- Modelo de incrustación: Procesa segmentos de texto individuales, extrayendo representaciones semánticas del estado oculto final.

- Modelo de reordenamiento: Toma pares de texto (por ejemplo, consulta y documento) y genera una puntuación de relevancia utilizando un enfoque cross-encoder.

- Los modelos de incrustación utilizan un paradigma de entrenamiento en tres etapas: preentrenamiento contrastivo, entrenamiento supervisado con datos de alta calidad y fusión de modelos para una generalización y adaptabilidad óptimas.

- Los modelos de reordenamiento se entrenan directamente con datos etiquetados de alta calidad para eficiencia y efectividad.

-

Soporte multilingüe y multitarea

- Soporta más de 100 idiomas, incluyendo lenguajes de programación, permitiendo capacidades robustas de recuperación multilingüe, translingüe y de código.

- Los modelos de incrustación permiten definiciones flexibles de vectores y instrucciones definidas por el usuario para adaptar el rendimiento a tareas o idiomas específicos.

-

Rendimiento y casos de uso

- Resultados de vanguardia en recuperación de texto, recuperación de código, clasificación, agrupamiento y minería de textos paralelos.

- Los modelos de reordenamiento destacan en varios escenarios de recuperación de texto y pueden combinarse de forma fluida con modelos de incrustación para pipelines de recuperación end-to-end.

Cómo usar en Ollama

Puedes ejecutar estos modelos en Ollama con comandos como:

ollama run dengcao/Qwen3-Embedding-8B:Q5_K_M

ollama run dengcao/Qwen3-Reranker-0.6B:F16

Elige la versión de cuantización que mejor se adapte a tus necesidades de hardware y rendimiento.

Tabla resumen

| Tipo de modelo | Tamaños disponibles | Fortalezas clave | Soporte multilingüe | Opciones de cuantización |

|---|---|---|---|---|

| Incrustación | 0.6B, 4B, 8B | Puntuaciones de MTEB de primer nivel, flexibles, eficientes, de vanguardia | Sí (100+ idiomas) | Q4, Q5, Q6, Q8, etc. |

| Reordenamiento | 0.6B, 4B, 8B | Destacan en la relevancia de pares de texto, eficientes, flexibles | Sí | F16, Q4, Q5, etc. |

Noticia increíble!

Los modelos de incrustación y reordenamiento de Qwen3 en Ollama representan un salto significativo en las capacidades de recuperación de texto y código multilingüe y multitarea. Con opciones de despliegue flexibles, un rendimiento sólido en benchmarks y soporte para una amplia gama de idiomas y tareas, están bien adaptados para entornos de investigación y producción.

Zoológico de modelos - placer para la vista ahora

Qwen3 Embedding

https://ollama.com/dengcao/Qwen3-Embedding-8B

https://ollama.com/dengcao/Qwen3-Embedding-4B/tags

https://ollama.com/dengcao/Qwen3-Embedding-0.6B/tags

Qwen3 Reranker

https://ollama.com/dengcao/Qwen3-Reranker-8B

dengcao/Qwen3-Reranker-8B:Q3_K_M

dengcao/Qwen3-Reranker-8B:Q5_K_M

https://ollama.com/dengcao/Qwen3-Reranker-4B/tags

dengcao/Qwen3-Reranker-4B:Q5_K_M

https://ollama.com/dengcao/Qwen3-Reranker-0.6B/tags

¡Genial!

Enlaces útiles

- Reordenamiento de documentos de texto con Ollama y modelo de incrustación Qwen3 - en Go

- Reordenamiento de documentos de texto con Ollama y modelo de reordenamiento Qwen3 - en Go

- Cheat sheet de Ollama

- Mover modelos de Ollama a un disco o carpeta diferente

- Autohospedaje de Perplexica - con Ollama

- Prueba: Cómo Ollama está usando el rendimiento de los núcleos de CPU de Intel

- Velocidad de rendimiento de LLM

- Comparación de las capacidades de resumen de LLM

- Proveedores de LLM en la nube

- Cómo Ollama maneja solicitudes paralelas

- Comparación de la calidad de traducción de páginas de Hugo - LLMs en Ollama