Top 17 aktuelle Python-Projekte auf GitHub

Trendende Python-Repos im Januar 2026

Das Python-Ökosystem dieses Monats wird von Claude Skills und AI-Agent-Tooling dominiert. Diese Übersicht analysiert die Top-Trending-Python-Repositorys auf GitHub.

Trendende Python-Repos im Januar 2026

Das Python-Ökosystem dieses Monats wird von Claude Skills und AI-Agent-Tooling dominiert. Diese Übersicht analysiert die Top-Trending-Python-Repositorys auf GitHub.

Trendende Rust-Repos im Januar 2026

Das Rust-Ökosystem erlebt einen Boom mit innovativen Projekten, insbesondere bei KI-Programmierwerkzeugen und Terminalanwendungen. Diese Übersicht analysiert die Top-Trending-Rust-Repositories auf GitHub dieses Monats.

Trendende Go-Repos im Januar 2026

Das Go-Ökosystem floriert weiterhin mit innovativen Projekten, die sich auf KI-Tools, selbstgehostete Anwendungen und Entwicklerinfrastruktur erstrecken. Diese Übersicht analysiert die Top-Trending-Go-Repositories auf GitHub diesen Monat.

Echte AUD-Preise von australischen Händlern jetzt

Der NVIDIA DGX Spark (GB10 Grace Blackwell) ist jetzt in Australien erhältlich bei großen PC-Händlern mit lokalem Lagerbestand. Wenn Sie die globale DGX Spark-Preisgestaltung und Verfügbarkeit verfolgt haben, werden Sie interessiert sein zu erfahren, dass die australischen Preise je nach Speicherkonfiguration und Händler zwischen 6.249 und 7.999 AUD liegen.

Senken Sie die LLM-Kosten um 80 % mit intelligenter Token-Optimierung

Tokenoptimierung ist die kritische Fähigkeit, die kosteneffiziente LLM-Anwendungen von budgetbelastenden Experimenten unterscheidet.

Bauen Sie MCP-Server für KI-Assistenten mit Python-Beispielen

Das Model Context Protocol (MCP) revolutioniert die Art und Weise, wie KI-Assistenten mit externen Datenquellen und Tools interagieren. In diesem Leitfaden erkunden wir, wie man MCP-Server in Python aufbaut, mit Beispielen, die sich auf Websuche und Scraping-Funktionen konzentrieren.

Verfügbarkeit, tatsächliche Einzelhandelspreise in sechs Ländern und Vergleich mit dem Mac Studio.

NVIDIA DGX Spark ist real, erhältlich ab dem 15. Oktober 2025 und richtet sich an CUDA-Entwickler, die lokale LLM-Arbeit mit einem integrierten NVIDIA AI-Stack benötigen. US-MSRP 3.999 $; UK/DE/JP Einzelhandel ist aufgrund von Mehrwertsteuer und Vertrieb höher. AUD/KRW öffentliche Preise sind noch nicht weit verbreitet.

Integrieren Sie Ollama mit Go: SDK-Anleitung, Beispiele und Produktions-Best-Praktiken.

Dieser Leitfaden bietet einen umfassenden Überblick über verfügbare Go SDKs für Ollama und vergleicht deren Funktionsumfänge.

Geschwindigkeit, Parameter und Leistung dieser beiden Modelle im Vergleich

Hier ist ein Vergleich zwischen Qwen3:30b und GPT-OSS:20b mit Fokus auf Befolgung von Anweisungen und Leistungsparametern, Spezifikationen und Geschwindigkeit:

+ Spezifische Beispiele unter Verwendung von Thinking LLMs

In diesem Beitrag werden wir zwei Möglichkeiten erkunden, Ihre Python-Anwendung mit Ollama zu verbinden: 1. Über die HTTP REST API; 2. Über die offizielle Ollama Python-Bibliothek.

Nicht sehr nett.

Ollamas GPT-OSS-Modelle haben wiederkehrende Probleme bei der Handhabung strukturierter Ausgaben, insbesondere bei der Verwendung mit Frameworks wie LangChain, OpenAI SDK, vllm und anderen.

Leicht unterschiedliche APIs erfordern einen speziellen Ansatz.

Hier ist ein Seitenvergleich der Unterstützung für strukturierte Ausgaben (zuverlässige JSON-Rückgabe) bei beliebten LLM-Anbietern, plus minimale Python-Beispiele

Einige Möglichkeiten, um strukturierte Ausgaben von Ollama zu erhalten

Große Sprachmodelle (LLMs) sind leistungsfähig, aber in der Produktion wollen wir selten frei formulierte Absätze. Stattdessen wollen wir vorhersehbare Daten: Attribute, Fakten oder strukturierte Objekte, die Sie in eine Anwendung einspeisen können. Das ist LLM-Strukturierte Ausgabe.

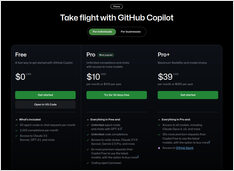

Beschreibung, Pläne, Befehle, Liste und Tastenkürzel

Hier ist ein aktueller GitHub Copilot Cheat Sheet, der wichtige Shortcuts, Befehle, Nutzungstipps und Kontextfunktionen für Visual Studio Code und Copilot Chat abdeckt

Langartikel über MCP-Spezifikationen und Implementierung in Go

Hier haben wir eine Beschreibung des Model Context Protocol (MCP), kurze Notizen zur Implementierung eines MCP-Servers in Go, einschließlich der Nachrichtenstruktur und Protokollspezifikationen.

RAG umsetzen? Hier sind einige Go-Code-Beispiele – 2...

Da das standardmäßige Ollama keinen direkten Rerank-API-Anschluss hat, müssen Sie Reranking mit Qwen3 Reranker in GO implementieren, indem Sie Embeddings für Abfrage-Dokument-Paare generieren und sie bewerten.