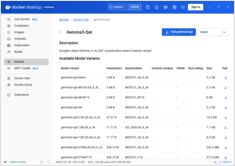

Lokales LLM-Hosting: Komplettführer 2026 – Ollama, vLLM, LocalAI, Jan, LM Studio & mehr

Meistern Sie die lokale Bereitstellung von LLMs mit einem Vergleich von 12+ Tools

Lokale Bereitstellung von LLMs ist zunehmend beliebt, da Entwickler und Organisationen eine verbesserte Privatsphäre, geringere Latenz und eine größere Kontrolle über ihre KI-Infrastruktur suchen.