Farfalle vs Perplexica

Een vergelijking van twee zelfgehoste AI zoekmachines

Prachtige voedsel is ook een genot voor de ogen. Maar in dit bericht vergelijken we twee AI-gebaseerde zoeksystemen, Farfalle en Perplexica.

Overigens heet deze vorm van pasta ook “farfalle”.

Maar hier vergelijk ik alleen hoe deze twee systemen zich gedragen. Niet de pasta-vormen.

OK. Concentreer je!

Zie ook Perplexica installatie en configuratie - met ollama en Installeer en configureer Ollama.

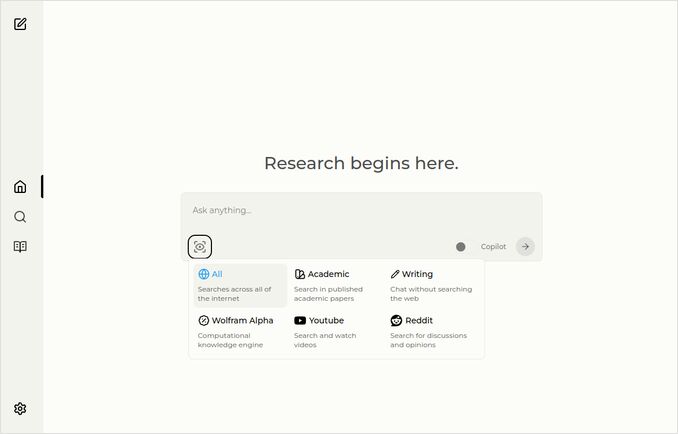

Perplexica

Hier is de homepage met een dropdown-menu voor bronselectie.

- Perplexica is uitgevoerd in

- TypeScript en React.Js (UI)

- TypeScript en Express.Js (Backend)

- bevat ook configuratie voor de SearxNG metasearch engine

- Heeft een Copilot-modus

- Heeft de mogelijkheid om elk Ollama-gehost LLM te gebruiken als chat- of embeddingsmodel

- Heeft drie kleine interne embeddingsmodellen

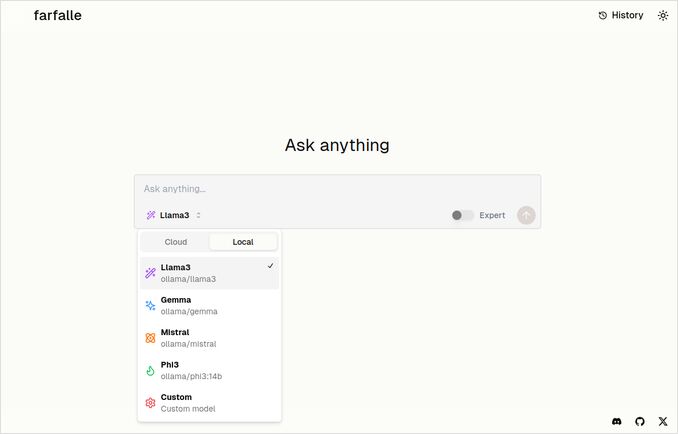

Farfalle

- Farfalle is uitgevoerd in

- TypeScript en React.Js (UI)

- Python Fastapi (Backend)

- bevat ook een verwijzing naar de SearxNG metasearch engine. Er is weinig configuratie voor dit laatste, het is vrijwel een standaard Docker-afbeelding.

- Heeft een Expert-modus die meerdere aanvragen moet voorbereiden op basis van de oorspronkelijke en de antwoorden combineren. Maar dit werkte niet in ons testscenario.

- Heeft de mogelijkheid om vier Ollama-gehoste LLMs te gebruiken als chatmodel (llama3, mistral, gemma, phi3). Dat is een goede set opties, maar ik zou het liever flexibeler willen maken en het toestaan om elk model te gebruiken dat Ollama serveert.

- Geen opties voor embeddingsmodel

Vergelijking uitgevoerd door Perplexica en Farfalle zelf

Ik heb dezelfde aanvraag gedaan Vergelijk farfalle en perplexica op basis van robuustheid, gemeenschap, ondersteuning en LLM ondersteund

Zowel Perplexica als Farfalle gebruikten de llama3 model die lokaal op ollama is gehost. Het volledige modelnaam is llama3 8b q4.

Geloof niet 100% wat de antwoorden zeggen, kijk alleen naar de tekstlengte, structuur en de kwaliteit van het antwoord over het algemeen.

Ik zou ongeveer 70% geloven…

Vergelijking van Perplexica

Vergelijking van Farfalle en Perplexica

Robuustheid

Farfalle: 8/10 - Farfalle is een populaire AI-zoekmachine die bekend staat om haar betrouwbaarheid en haar vermogen om complexe vragen te verwerken. Ze heeft een sterke basis in natuurlijke taalverwerking (NLP) en machine learning (ML). Hoewel het niet perfect is, is de robuustheid van Farfalle goed gevestigd.

Perplexica: 9/10 - Perplexica is gebouwd op Meta AI’s Phi-3 model, dat is ontworpen voor robuustheid. Het is getest om accuraat antwoorden te geven zelfs bij onduidelijke of onduidelijke vragen. Het vermogen om vragen te herformuleren en aan te passen aan verschillende contexten maakt het een robuuste zoekmachine.

Gemeenschap

Farfalle: 7/10 - Farfalle heeft een toegewijde gemeenschap van gebruikers die haar mogelijkheden waarderen. Hoewel het niet hetzelfde niveau van adoptie heeft als Perplexica, is de gebruikersgroep van Farfalle nog steeds aanzienlijk.

Perplexica: 8.5/10 - Perplexica heeft veel aandacht gekregen voor haar innovatieve aanpak van zoekmachines. Zijn gemeenschap groeit snel, met veel gebruikers die waarderen dat het accuraat en relevante resultaten kan geven.

Ondersteuning

Farfalle: 6.5/10 - Farfalle biedt basisondersteuning via FAQs, documentatie en forums. Hoewel het niet zo uitgebreid is als Perplexica’s ondersteuning, is de gebruikersgroep van Farfalle over het algemeen zelfstandig.

Perplexica: 9/10 - Perplexica biedt uitgebreide ondersteuningsresources, waaronder gedetailleerde documentatie, FAQs en communityforums. Zijn ontwikkelaars zijn actief betrokken bij de gemeenschap, zodat gebruikers tijdelijk en effectief hulp krijgen.

Ondersteunde LLMs

Farfalle: Nee - Farfalle is een zelfstandige AI-zoekmachine die niet afhankelijk is van grote taalmodellen (LLMs) voor haar mogelijkheden.

Perplexica: Ja - Perplexica is gebouwd op Meta AI’s Phi-3 model, dat een LLM is. Dit laat Perplexica de kracht van diepe leerprocessen gebruiken voor meer accuraat en relevante resultaten.

Totale score Farfalle: 22/30 Perplexica: 34.5/40

Op basis van deze criteria lijkt Perplexica een klein voordeel te hebben over Farfalle in termen van robuustheid, gemeenschapsondersteuning en LLM-integratie. Toch hebben beide zoekmachines hun sterke punten, en de keuze hangt uiteindelijk af van uw specifieke behoeften en voorkeuren.

Aanbeveling Als u op zoek bent naar een betrouwbare AI-zoekmachine met sterke NLP-mogelijkheden, kan Perplexica de betere keuze zijn. Als u een eenvoudigere, minder ingewikkelde aanpak voor zoekmachines prefereert, kan Farfalle nog steeds uitstekende resultaten bieden.

Vergelijking van Farfalle

Vergelijking van Farfalle en Perplexica

Farfalle en Perplexica zijn twee AI-gebaseerde zoekmachines die recent aandacht hebben gekregen. Hieronder volgt een vergelijking van deze twee projecten op basis van robuustheid, gemeenschap, ondersteuning en LLM (Large Language Model) ondersteuning.

Robuustheid

- Farfalle is ontworpen om zelfgehost te worden met lokale of cloud LLMs, waardoor het een robuustere optie is voor gebruikers die controle willen over hun zoekmachine.

- Perplexica is daarentegen een open-source alternatief voor Perplexity AI en wordt constant verbeterd door de ontwikkelaars.

Gemeenschap

- Perplexica heeft een toegewijde gemeenschap van ontwikkelaars en gebruikers die bijdragen aan de ontwikkeling en ondersteuning

- De gemeenschap van Farfalle is kleiner, maar heeft nog steeds een aanwezigheid op GitHub

Ondersteuning

- Perplexica biedt regelmatige updates en verbeteringen, evenals een Discord-kanaal voor het bespreken van onderwerpen buiten de reguliere ondersteuning

- De ondersteuning van Farfalle is beperkt tot GitHub-issues en pull requests

LLM-ondersteuning Beide Farfalle en Perplexica ondersteunen LLMs. Perplexica gebruikt Ollama, een lokale LLM, terwijl Farfalle zowel lokale als cloud LLMs ondersteunt.

In samenvatting is Farfalle robuuster vanwege zijn zelfgehoste ontwerp, terwijl Perplexica een sterkerere gemeenschap en betere ondersteuning heeft. Beide projecten ondersteunen LLMs, maar Perplexica gebruikt Ollama specifiek.

Conclusie

Wat is het verschil tussen Perplexica en Farfalle?

Het antwoord:

- Opzij gezien enkele feitelijke fouten, denken beide systemen dat Perplexica beter is dan Farfalle, wat ik graag zou willen stemmen mee.

- Ik vind de gebruikersinterface van Farfalle echt leuk, al zijn ze vrij dicht bij elkaar

- Ik vind het idee van de expertmodus van Farfalle leuk, al werkte deze niet in mijn omgeving

- Ik kwam drie bugs tegen bij het uitvoeren van Farfalle. De code van Perplexica is beter afgerond

- Zodra het is geconfigureerd, liep Perplexica zonder fouten

- Perplexica toestaat het gebruik van elk Ollama-gehost model. Farfalle toestaat het gebruik van alleen Gemma, Llama3, Mistral en Phi3 (vooraf gedefinieerde versies, die iets verouderd zijn).

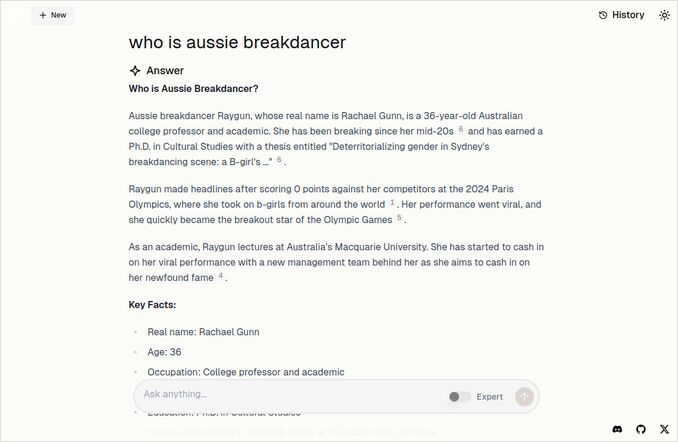

- Ik vind de antwoorden van Farfalle leuker. Kijk naar de onderstaande afbeelding van Farfalle. Recht op het punt zonder die “Volgens de context die is gegeven”…

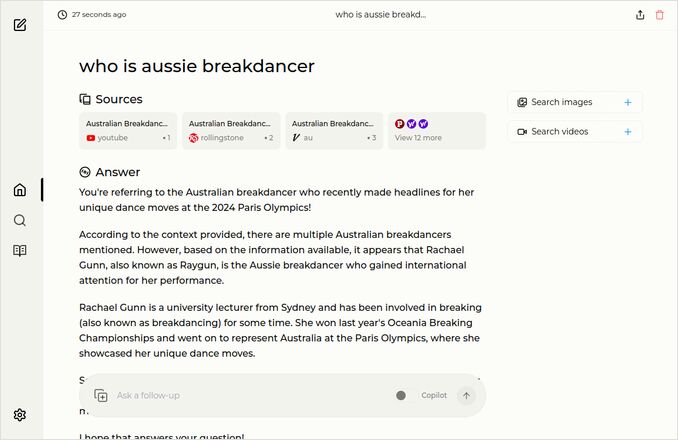

Meer voorbeelden

Deze tonen antwoorden voor dezelfde vraag over de Australische breakdancer. Weet je, diegene met een doctoraat die 0 (nul) punten kreeg en waarschijnlijk de breakdancing uit het olympische programma heeft verwijderd.

Farfalle antwoord

Perplexica antwoord

Als je deze laatste paragraaf leest (of leest), dankjewel dat je dezelfde interesses hebt als ik. Het is echt opwindende tijden. Heb een fijne dag!

Nuttige links

- Zoeken vs Deepsearch vs Deep Research

- Test: Hoe Ollama Intel CPU-prestaties en efficiënte cores gebruikt

- Hoe Ollama parallele aanvragen verwerkt

- Self-hosting Perplexica - met Ollama

- Vergelijking van LLM samenvattingsmogelijkheden

- Effectief schrijven van prompts voor LLMs

- Testen van logische foutdetectie door nieuwe LLMs: gemma2, qwen2 en mistral Nemo

- Ollama cheat sheet

- Markdown Cheat sheet

- Cloud LLM Providers

- Qwen3 Embedding & Reranker Models op Ollama: State-of-the-Art Performance