मिस्ट्रल स्मॉल, जेम्मा 2, क्वेन 2.5, मिस्ट्रल नेमो, एलएलएम3 और फ़ी - एलईएम परीक्षण

एलएलएम परीक्षणों का अगला चरण

कुछ समय पहले जारी किया गया था। चलिए अपडेट करते हैं और

मिस्ट्रल स्मॉल के प्रदर्शन की तुलना करके टेस्ट करें।

एलएलएम परीक्षणों का अगला चरण

कुछ समय पहले जारी किया गया था। चलिए अपडेट करते हैं और

मिस्ट्रल स्मॉल के प्रदर्शन की तुलना करके टेस्ट करें।

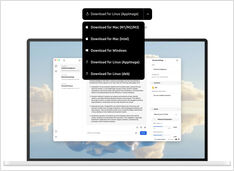

एकीकरण प्रणाली विकल्प

समाकलन प्रणाली भुगतान के लिए बहुत सारे विशेष विशेषता वाले मॉड्यूल हो सकते हैं और कुछ अपने आप में निःशुल्क हो सकते हैं; या कुछ अजीब लाइसेंस के साथ लगभग निःशुल्क हो सकते हैं; या स्व-मेजबानी के लिए तैयार और नहीं।

यासी एक पी2पी स्व-मेजबान खोज इंजन है।

यासी एक वितरित, समाज के बीच एक-दूसरे के साथ (P2P) खोज इंजन है जो व्यक्तियों और संगठनों को अपने खोज द्वारों को चलाने या एक वैश्विक खोज समाज के नेटवर्क में शामिल होने की अनुमति देता है।

चरण-दर-चरण निर्देश

हाउ-टू: केब्सप्रे द्वारा केबरनेट्स की स्थापना, जिसमें पर्यावरण के सेटअप, इनवेंटरी के संगठन और एंसिबल प्लेबुक्स के चलाने को शामिल करता है।

कुछ आम k8s कमांड्स पैरामीटर के साथ

यहाँ मेरा k8s टिप्पणी शीट है, जो कुबेरनेट्स के महत्वपूर्ण कमांड और अवधारणाओं को कवर करता है, जिसमें इंस्टॉल करने से लेकर कंटेनर चलाने और साफ करने तक के विषय शामिल हैं:

कुछ आम डॉकर कमांड पैरामीटर

यहाँ एक Docker टिप्पणी शीट है जो महत्वपूर्ण कमांड और डॉकर के इस्तेमाल से लेकर कंटेनर चलाने और साफ करने तक के अवधारणाओं को कवर करती है:

अद्भुत नई AI मॉडल पाठ से चित्र उत्पन्न करने के लिए

हाल ही में ब्लैक फॉरेस्ट लैब्स ने एक सेट

टेक्स्ट-टू-इमेज आर्टिफिशियल इंटेलिजेंस मॉडल का प्रकाशन किया है।

इन मॉडलों के उत्पादन गुणवत्ता बहुत अधिक है।

इन्हें आज़माएं

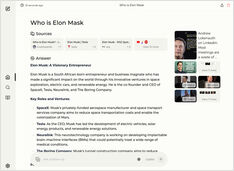

दो स्व-होस्ट किए गए AI खोज इंजन की तुलना

अद्भुत खाद्य पदार्थ आपके आंखों के लिए भी आनंद है।

लेकिन इस पोस्ट में हम दो AI आधारित खोज प्रणालियों, Farfalle और Perplexica की तुलना करेंगे।

क्या आपलोग लॉकल में Copilot-स्टाइल सर्विस चलाना चाहते हैं? बहुत आसान!

यह बहुत दिलचस्प है! ऐसे कोपाइलट (copilot) या पर्फ़्लेक्सिटी.एआई (perplexity.ai) जैसे सेवाओं को नामकरण देते हुए, और दुनिया को बताते हुए आप क्या चाहते हैं, आप अब इस प्रकार की सेवाओं को खुद के पीसी (PC) या लैपटॉप (laptop) पर आज़माई कर सकते हैं!

कुछ कम विकल्प हैं लेकिन फिर भी....

जब मैंने LLMs के साथ प्रयोग शुरू किया तो उनके UIs गतिशील विकास में थे और अब कुछ बहुत अच्छे हैं।

तार्किक भ्रम पता करना पर परीक्षण

हाल ही में हमने कई नए LLMs के रिलीज को देखा है।

उत्साहजनक समय है।

चलिए टेस्ट करें और देखें कि वे तार्किक गलतियों के पता लगाने में कैसे प्रदर्शन करते हैं।

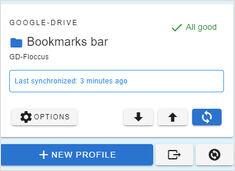

लैपटॉप और ब्राउज़र्स के बीच बुकमार्क सिंक करना?

मैंने अलग-अलग उपकरणों का उपयोग करके अपने अनुभव से निष्कर्ष निकाला है कि मुझे floccus सबसे अच्छा लगता है।

लेबलिंग और ट्रेनिंग में कुछ चिपकाना आवश्यक है

जब मैं object detector AI का ट्रेन कर रहा था कुछ समय पहले - LabelImg एक बहुत सहायक टूल था, लेकिन Label Studio से COCO फॉर्मेट में एक्सपोर्ट MMDetection फ्रेमवर्क द्वारा स्वीकृत नहीं था।

8 llama3 (Meta+) and 5 phi3 (Microsoft) LLM versions

Please see the English page version.

ओलामा एलईएम मॉडल फ़ाइलें काफ़ी स्पेस लेती हैं

इंस्टॉल करने के बाद ओलामा को तुरंत नए स्थान पर संगठित करना बेहतर होगा, ताकि नए मॉडल खींचे जाने के बाद वे पुराने स्थान पर डाउनलोड न हों।