मिस्ट्रल स्मॉल, जेम्मा 2, क्वेन 2.5, मिस्ट्रल नेमो, एलएलएम3 और फ़ी - एलईएम परीक्षण

एलएलएम परीक्षणों का अगला चरण

कुछ समय पहले जारी किया गया था। चलिए अपडेट करते हैं और

मिस्ट्रल स्मॉल के प्रदर्शन की तुलना करके टेस्ट करें।

एलएलएम परीक्षणों का अगला चरण

कुछ समय पहले जारी किया गया था। चलिए अपडेट करते हैं और

मिस्ट्रल स्मॉल के प्रदर्शन की तुलना करके टेस्ट करें।

एक पायथन कोड जो RAG के पुनर्रैंकिंग को दर्शाता है

अद्भुत नई AI मॉडल पाठ से चित्र उत्पन्न करने के लिए

हाल ही में ब्लैक फॉरेस्ट लैब्स ने एक सेट

टेक्स्ट-टू-इमेज आर्टिफिशियल इंटेलिजेंस मॉडल का प्रकाशन किया है।

इन मॉडलों के उत्पादन गुणवत्ता बहुत अधिक है।

इन्हें आज़माएं

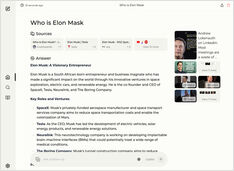

दो स्व-होस्ट किए गए AI खोज इंजन की तुलना

अद्भुत खाद्य पदार्थ आपके आंखों के लिए भी आनंद है।

लेकिन इस पोस्ट में हम दो AI आधारित खोज प्रणालियों, Farfalle और Perplexica की तुलना करेंगे।

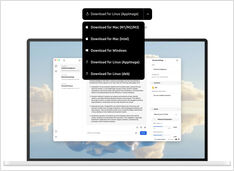

क्या आपलोग लॉकल में Copilot-स्टाइल सर्विस चलाना चाहते हैं? बहुत आसान!

यह बहुत दिलचस्प है! ऐसे कोपाइलट (copilot) या पर्फ़्लेक्सिटी.एआई (perplexity.ai) जैसे सेवाओं को नामकरण देते हुए, और दुनिया को बताते हुए आप क्या चाहते हैं, आप अब इस प्रकार की सेवाओं को खुद के पीसी (PC) या लैपटॉप (laptop) पर आज़माई कर सकते हैं!

कुछ कम विकल्प हैं लेकिन फिर भी....

जब मैंने LLMs के साथ प्रयोग शुरू किया तो उनके UIs गतिशील विकास में थे और अब कुछ बहुत अच्छे हैं।

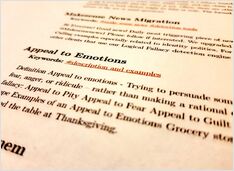

तार्किक भ्रम पता करना पर परीक्षण

हाल ही में हमने कई नए LLMs के रिलीज को देखा है।

उत्साहजनक समय है।

चलिए टेस्ट करें और देखें कि वे तार्किक गलतियों के पता लगाने में कैसे प्रदर्शन करते हैं।

कुछ प्रयोग की आवश्यकता है लेकिन

अभी भी कुछ सामान्य दृष्टिकोण हैं जिनके द्वारा अच्छे प्रॉम्प्ट लिखे जा सकते हैं ताकि LLM को आपके द्वारा चाहे वाले कार्य को समझने में भ्रमित न हो।

8 llama3 (Meta+) and 5 phi3 (Microsoft) LLM versions

Please see the English page version.

ओलामा एलईएम मॉडल फ़ाइलें काफ़ी स्पेस लेती हैं

इंस्टॉल करने के बाद ओलामा को तुरंत नए स्थान पर संगठित करना बेहतर होगा, ताकि नए मॉडल खींचे जाने के बाद वे पुराने स्थान पर डाउनलोड न हों।

चलो एलईएम के ग्राफिक्स प्रोसेसर और सीपीयू पर गति का परीक्षण करते हैं।

कई LLMs के विभिन्न संस्करणों (llama3 (मेटा/फेसबुक), phi3 (माइक्रोसॉफ्ट), gemma (गूगल), mistral (ओपन स्रोत)) के पूर्वानुमान गति की तुलना: CPU और GPU पर।

भिन्न-भिन्न एलएलएम्स की तार्किक त्रुटि पहचान की गुणवत्ता का परीक्षण करें

मैं कई LLM संस्करणों की तुलना कर रहा हूँ: Llama3 (Meta), Phi3 (Microsoft), Gemma (Google), Mistral (Mistral AI) और Qwen (Alibaba).