م Mistral Small، Gemma 2، Qwen 2.5، Mistral Nemo، LLama3 و Phi - اختبار نماذج اللغات الكبيرة

الجولة التالية من اختبارات النماذج الكبيرة

لم تمرّ فترة طويلة منذ إصداره. دعنا ن迎头赶上 وTest how Mistral Small performs comparing to other LLMs.

الجولة التالية من اختبارات النماذج الكبيرة

لم تمرّ فترة طويلة منذ إصداره. دعنا ن迎头赶上 وTest how Mistral Small performs comparing to other LLMs.

كود بايثون لإعادة الترتيب في RAG

إعادة الترتيب هو خطوة ثانية في توليد المحتوى المعزز بالاسترجاع (RAG) الأنظمة, بين الاسترجاع والتكوين.

نموذج الذكاء الاصطناعي الرائع الجديد لتوليد صورة من النص

في الآونة الأخيرة أصدرت مختبرات Black Forest مجموعة من نماذج الذكاء الاصطناعي لتحويل النص إلى صورة. تُقال إن هذه النماذج تنتج صورًا ذات جودة أعلى بكثير. لنحاول استخدامها

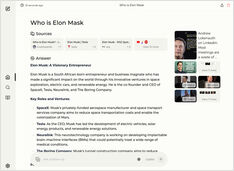

مقارنة بين محركي بحث الذكاء الاصطناعي الذاتيين

الطعام الرائع هو متعة للعين أيضًا. لكن في هذه المقالة، سنقارن بين نظامي بحث قائمين على الذكاء الاصطناعي، Farfalle و Perplexica.

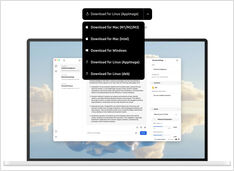

هل ترغب في تشغيل خدمة من نوع كوبيلو محليًا؟ سهل جدًا!

هذا أمر مثير للغاية! بدلاً من الاتصال بـ copilot أو perplexity.ai وإخبار العالم بأكمله بما تبحث عنه، يمكنك الآن تشغيل خدمة مشابهة على جهاز الكمبيوتر أو الحاسوب المحمول الخاص بك!

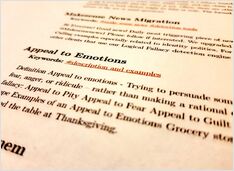

اختبار اكتشاف الأخطاء المنطقية

في الآونة الأخيرة، شهدنا إصدار عدد من النماذج الجديدة من LLMs. أوقات مثيرة. لنختبر ونرى كيف تؤدي الأداء عند اكتشاف الخطا المنطقية.

ليس هناك الكثير可供选择 ولكن ما زال هناك...

عندما بدأت بتجربة النماذج الكبيرة للغة (LLMs)، كانت واجهات المستخدم الخاصة بها في التطوير النشط، و اليوم أصبحت بعضها جيدة حقًا.

يتطلب بعض التجريب ولكن

ما زال هناك بعض الأساليب الشائعة لكتابة محفزات جيدة بحيث لا يشعر النموذج اللغوي الضخم (LLM) بالارتباك عند محاولة فهم ما تريده منه.

8 نسخة من llama3 (Meta+) و5 نسخ من phi3 (Microsoft) من نماذج LLM

اختبار كيف تؤثر النماذج ذات عدد مختلف من المعلمات والكم量化 على الأداء.

تستغرق ملفات نموذج Ollama LLM مساحة كبيرة جدًا.

بعد تثبيت ollama من الأفضل إعادة تكوين ollama لتخزينها في مكان جديد فورًا. إذن بعد أن نسحب نموذجًا جديدًا، لن يتم تنزيله إلى الموقع القديم.

لنختبر سرعة النماذج الكبيرة للغة على وحدة معالجة الرسومات (GPU) مقابل وحدة المعالجة المركزية (CPU)

مقارنة سرعة التنبؤ لعدة إصدارات من نماذج LLMs: llama3 (Meta/Facebook)، phi3 (Microsoft)، gemma (Google)، mistral (مصدر مفتوح) على وحدة المعالجة المركزية (CPU) ووحدة معالجة الرسومات (GPU).

لنختبر جودة اكتشاف الأخطاء المنطقية في نماذج LLM المختلفة

هنا أنا أقارن بين عدة إصدارات من نماذج LLM: Llama3 (Meta)، Phi3 (Microsoft)، Gemma (Google)، Mistral Nemo (Mistral AI) وQwen (Alibaba).