Farfalle 与 Perplexica

比较两款自托管AI搜索引擎

美味的食物不仅令人垂涎,也是一道视觉盛宴。

但在这篇文章中,我们将比较两个基于人工智能的搜索系统,Farfalle 和 Perplexica。

顺便提一下,这种意大利面的形状也被称为“farfalle”。

但在这里,我只比较这两个系统的行为,而不是意大利面的形状。

好的,集中注意力!

请参阅以下内容:

Perplexica 安装和配置 - 使用 ollama

以及

安装和配置 Ollama。

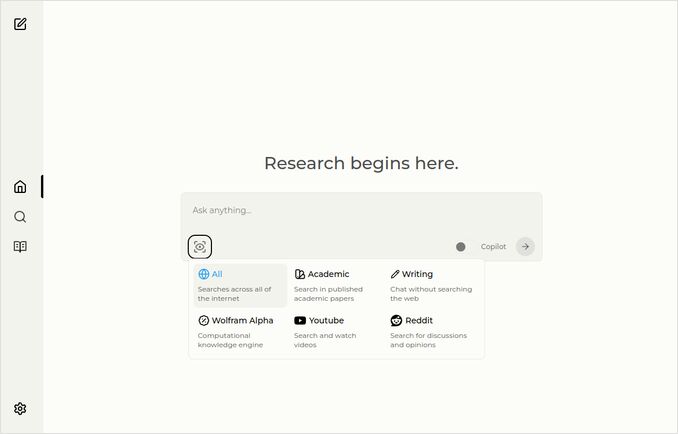

Perplexica

这是带有源选择下拉菜单的主页。

- Perplexica 是用以下技术实现的:

- TypeScript 和 React.Js(UI)

- TypeScript 和 Express.Js(后端)

- 还包括 SearxNG 元搜索引擎的配置

- 具有 Copilot 模式

- 可以使用任何 Ollama 主机的 LLM 作为聊天或嵌入模型

- 有三个小型内部嵌入模型

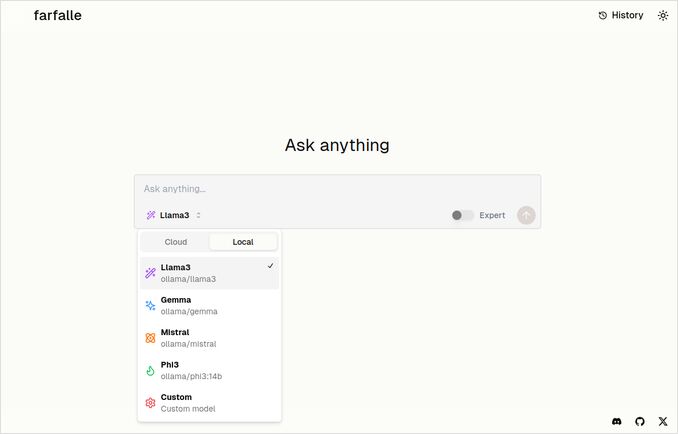

Farfalle

- Farfalle 是用以下技术实现的:

- TypeScript 和 React.Js(UI)

- Python Fastapi(后端)

- 还包括 SearxNG 元搜索引擎的参考。对此的配置不多,基本上是标准的 Docker 镜像。

- 具有 Expert 模式,应该能从原始请求中生成多个请求并合并响应。但在我们的测试中,这并未正常工作。

- 可以使用四个 Ollama 主机的 LLM 作为聊天模型(llama3、mistral、gemma、phi3)。这是一组不错的选择,但我希望它能更灵活,允许使用 Ollama 提供的任何模型。

- 没有嵌入模型的选项

由 Perplexica 和 Farfalle 本身进行的比较

我运行了相同的请求:

根据鲁棒性、社区、支持和所支持的 LLM 对 Farfalle 和 Perplexica 进行比较

Perplexica 和 Farfalle 都使用本地 Ollama 上的 llama3 模型。

该模型的全名是 llama3 8b q4。

不要百分之百相信响应内容,只需查看文本长度、结构和整体响应质量。

我大概相信约 70%…

Perplexica 比较响应

Farfalle 和 Perplexica 的比较

鲁棒性

Farfalle:8/10 - Farfalle 是一个广受欢迎的人工智能搜索引擎,以其可靠性和处理复杂查询的能力而闻名。它在自然语言处理(NLP)和机器学习(ML)方面有坚实的基础。虽然它可能不是完美的,但 Farfalle 的鲁棒性已经得到了充分的验证。

Perplexica:9/10 - Perplexica 基于 Meta AI 的 Phi-3 模型构建,该模型旨在实现鲁棒性。它已被测试,即使在面对模糊或不明确的查询时也能提供准确的答案。它能够重新表述问题并适应不同上下文的能力使其成为一个强大的搜索引擎。

社区

Farfalle:7/10 - Farfalle 有一个致力于其功能的用户社区。虽然它的采用率可能不如 Perplexica,但 Farfalle 的用户群仍然相当可观。

Perplexica:8.5/10 - Perplexica 因其对搜索引擎的创新方法而广受认可。其社区正在迅速增长,许多用户赞赏其提供准确和相关结果的能力。

支持

Farfalle:6.5/10 - Farfalle 通过常见问题解答、文档和论坛提供基本支持。虽然不如 Perplexica 的支持全面,但 Farfalle 的用户群通常能够自我解决。

Perplexica:9/10 - Perplexica 提供了广泛的支持资源,包括详细的文档、常见问题解答和社区论坛。其开发人员积极与社区互动,确保用户能够及时获得有效的帮助。

所支持的 LLM

Farfalle:无 - Farfalle 是一个独立的人工智能搜索引擎,不依赖大型语言模型(LLM)来实现其功能。

Perplexica:有 - Perplexica 基于 Meta AI 的 Phi-3 模型构建,这是一个 LLM。这使得 Perplexica 能够利用深度学习的力量,提供更准确和相关的结果。

总体评分:Farfalle:22/30,Perplexica:34.5/40

根据这些标准,Perplexica 在鲁棒性、社区支持和 LLM 集成方面似乎略胜于 Farfalle。然而,这两个搜索引擎各有其优势,最终的选择取决于您的具体需求和偏好。

建议:如果您正在寻找一个具有强大 NLP 能力的可靠人工智能搜索引擎,Perplexica 可能是更好的选择。如果您更倾向于一个简单、无花哨的搜索方式,Farfalle 仍然可以提供出色的结果。

Farfalle 比较响应

Farfalle 和 Perplexica 的比较

Farfalle 和 Perplexica 是两个近期受到关注的人工智能搜索引擎。以下是基于鲁棒性、社区、支持和 LLM(大型语言模型)支持的比较。

鲁棒性

- Farfalle 设计为可本地或云端运行的自托管搜索引擎,使其成为希望控制其搜索引擎的用户更强大的选择。

- Perplexica 是 Perplexity AI 的一个开源替代品,其开发人员不断对其进行改进。

社区

- Perplexica 有一个致力于其开发和提供支持的开发者和用户社区。

- Farfalle 的社区规模较小,但在 GitHub 上仍有一定的存在。

支持

- Perplexica 提供定期更新和改进,并且有一个 Discord 频道用于讨论超出常规支持范围的问题。

- Farfalle 的支持仅限于 GitHub 的问题和拉取请求。

LLM 支持

- Farfalle 和 Perplexica 都支持 LLM。Perplexica 使用 Ollama,这是一个本地 LLM,而 Farfalle 支持本地和云端 LLM。

总结:由于其自托管设计,Farfalle 更加鲁棒,而 Perplexica 拥有更强大的社区和更好的支持。两者都支持 LLM,但 Perplexica 特别使用 Ollama。

结论

Perplexica 和 Farfalle 之间的区别是什么?

答案如下:

- 忽略一些事实错误,两个系统都认为 Perplexica 比 Farfalle 更好,我倾向于同意这一点。

- 我真的很喜欢 Farfalle 的用户界面,尽管它们非常接近。

- 我喜欢 Farfalle 的专家模式的想法,尽管在我的环境中它没有正常工作。

- 在运行 Farfalle 时,我遇到了 3 个错误。Perplexica 的代码更完善。

- 一旦配置好,Perplexica 就能无错误地运行。

- Perplexica 允许使用任何 Ollama 主机的模型。而 Farfalle 只允许使用 Gemma、Llama3、Mistral 和 Phi3(预定义版本,这些版本稍微有些过时)。

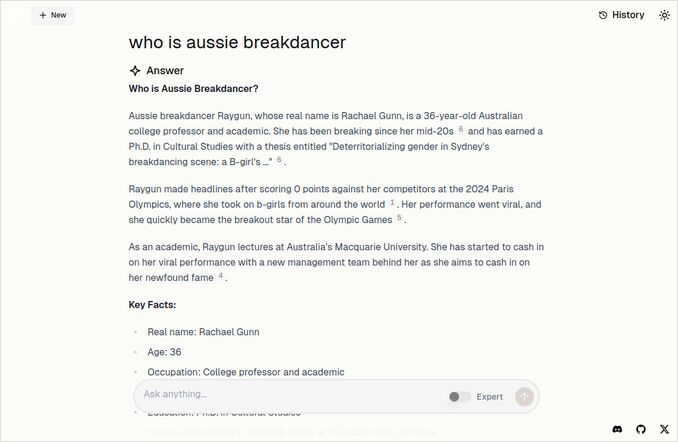

- 我更喜欢 Farfalle 的响应。请看下面的 Farfalle 图像。直接切入主题,而不是那些“根据提供的上下文”…

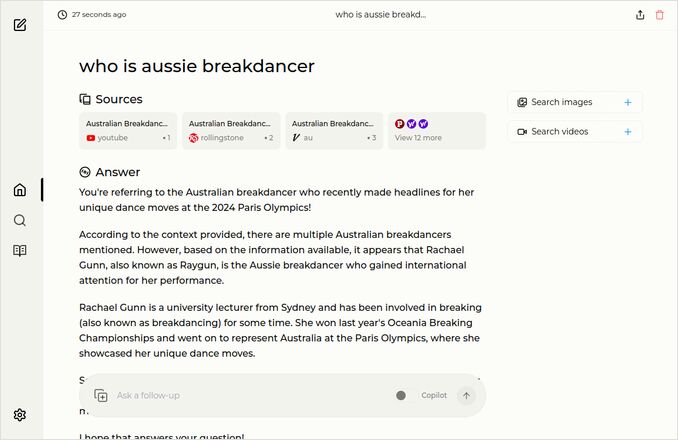

更多示例

这些展示了对同一个关于澳大利亚霹雳舞者的问题的响应。

你知道,那个拥有博士学位却得了 0(零)分,可能让霹雳舞被从奥运会项目中移除的人。

Farfalle 的响应

Perplexica 的响应

如果你读完(或读完)了最后一段,感谢你与我有相同的兴趣。现在真是令人激动的时期。

祝你有美好的一天!