Pindahkan Model Ollama ke Lokasi yang Berbeda

Berkas model LLM Ollama memakan banyak ruang.

Setelah memasang ollama lebih baik mengonfigurasi ulang ollama untuk menyimpannya di lokasi baru segera. Jadi setelah kita menarik model baru, tidak akan didownload ke lokasi lama.

Tentang Ollama

Ollama adalah frontend berbasis teks untuk LLM AI Models dan API yang dapat menjalankan model-model tersebut.

Instalasi Ollama

Buka https://ollama.com/download

Untuk menginstal Ollama di Linux:

curl -fsSL https://ollama.com/install.sh | sh

Ollama di Windows ada di halaman: https://ollama.com/download/windows Ollama untuk Mac juga tersedia di sana: https://ollama.com/download/macOllamaSetup.exe

Mengunduh, Menampilkan, dan Menghapus Model Ollama

Untuk mengunduh beberapa model Ollama: Buka Ollama Library (https://ollama.com/library) dan cari model yang Anda butuhkan, di sana Anda juga dapat menemukan tag dan ukuran model.

Kemudian jalankan:

ollama pull gemma2:latest

# Atau dapatkan yang sedikit lebih cerdas tetapi masih cocok dengan 16GB VRAM:

ollama pull gemma2:27b-instruct-q3_K_S

# Atau:

ollama pull llama3.1:latest

ollama pull llama3.1:8b-instruct-q8_0

ollama pull mistral-nemo:12b-instruct-2407-q6_K

ollama pull mistral-small:22b-instruct-2409-q4_0

ollama pull phi3:14b-medium-128k-instruct-q6_K

ollama pull qwen2.5:14b-instruct-q5_0

Untuk memeriksa model apa saja yang Ollama miliki di repositori lokal:

ollama list

Untuk menghapus model yang tidak diperlukan:

ollama rm qwen2:7b-instruct-q8_0 # sebagai contoh

Lokasi Model Ollama

Secara default, file model disimpan di:

- Windows: C:\Users%username%.ollama\models

- Linux: /usr/share/ollama/.ollama/models

- macOS: ~/.ollama/models

Mengonfigurasi Lokasi Model Ollama di Windows

Untuk membuat variabel lingkungan di Windows, ikuti instruksi berikut:

- Buka Pengaturan Windows.

- Pergi ke Sistem.

- Pilih Tentang

- Pilih Pengaturan Sistem Lanjutan

- Pergi ke tab Lanjutan.

- Pilih Variabel Lingkungan…

- Klik pada New…

- Dan buat variabel yang disebut OLLAMA_MODELS yang menunjuk ke tempat Anda ingin menyimpan model

Memindahkan Model Ollama di Linux

Edit parameter layanan ollama systemd

sudo systemctl edit ollama.service

atau

sudo xed /etc/systemd/system/ollama.service

Ini akan membuka editor.

Untuk setiap variabel lingkungan, tambahkan baris Environment di bawah bagian [Service]:

[Service]

Environment="OLLAMA_MODELS=/specialplace/ollama/models"

Simpan dan keluar.

Ada juga parameter User dan Group, yang harus memiliki akses ke folder ini.

Muat ulang systemd dan restart Ollama:

sudo systemctl daemon-reload

sudo systemctl restart ollama

jika ada yang salah

systemctl status ollama.service

sudo journalctl -u ollama.service

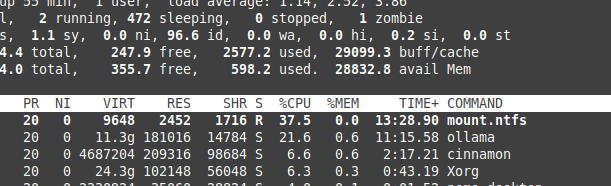

Penyimpanan file pada NTFS overhead

Harap diperhatikan bahwa jika Anda menjalankan linux dan menyimpan model Anda pada partisi yang diformat NTFS, model Anda akan memuat jauh lebih lambat, lebih dari 20% lebih lambat.

Menginstal Ollama di Windows ke folder tertentu

Bersama dengan model

.\OllamaSetup.exe /DIR=D:\OllamaDir

Menampilkan API Ollama ke jaringan internal

Internal di sini berarti jaringan lokal.

Tambahkan ke konfigurasi layanan:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Tautan yang berguna

- Uji: Bagaimana Ollama Menggunakan Kinerja dan Inti Efisien CPU Intel

- Bagaimana Ollama Mengelola Permintaan Paralel

- Uji Deepseek-r1 di Ollama

- Kinerja LLM dan Jalur PCIe: Pertimbangan Penting

- Deteksi Kesalahan Logis dengan LLMs

- Perbandingan Kinerja Kecepatan LLM

- Membandingkan Kemampuan Ringkasan LLM

- Menulis Prompt yang Efektif untuk LLMs

- Menghosting Perplexica Secara Mandiri - dengan Ollama

- Kartu Perintah Conda

- Kartu Perintah Docker

- Pemasok LLM di Cloud

- Model Embedding & Reranker Qwen3 di Ollama: Kinerja Terbaik