फारफैले वर्सस पर्प्लेक्सिका

दो स्व-होस्ट किए गए AI खोज इंजन की तुलना

अद्भुत खाद्य पदार्थ आपके आंखों के लिए भी आनंद है।

लेकिन इस पोस्ट में हम दो AI आधारित खोज प्रणालियों, Farfalle और Perplexica की तुलना करेंगे।

दुर्भाग्य से, यह पास्ता के आकार को “farfalle” कहा जाता है।

लेकिन यहां मैं केवल इन दो प्रणालियों के व्यवहार की तुलना कर रहा हूं। पास्ता के आकार नहीं।

ठीक है। सावधान रहें!

कृपया देखें

Perplexica की स्थापना और विन्यास - ollama के साथ

और

ओलामा की स्थापना और विन्यास।

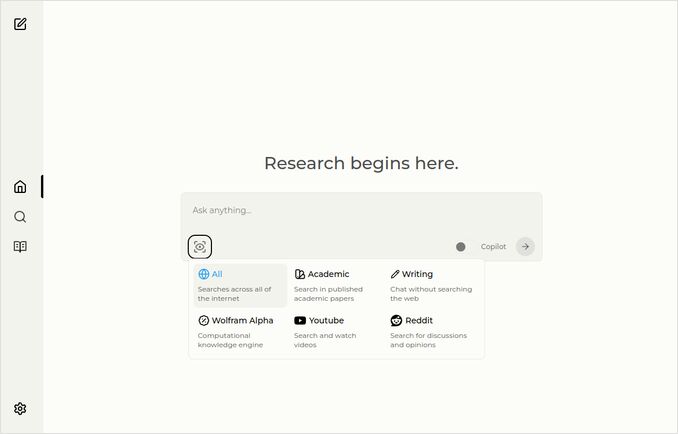

Perplexica

यहां स्रोत चयन ड्रॉपडाउन के साथ होम पेज है।

- Perplexica को इस प्रकार लागू किया गया है:

- TypeScript और React.Js (UI)

- TypeScript और Express.Js (बैकएंड)

- SearxNG मेटाखोज इंजन के लिए विन्यास भी शामिल है

- एक कॉपिलॉट मोड है

- किसी भी Ollama-मेजबान LLM का उपयोग करने की क्षमता है, चैट या एम्बेडिंग मॉडल के रूप में

- तीन छोटे आंतरिक एम्बेडिंग मॉडल हैं

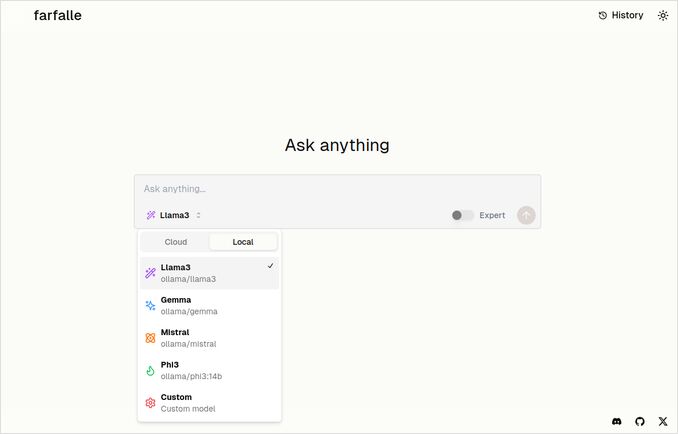

Farfalle

- Farfalle को इस प्रकार लागू किया गया है:

- TypeScript और React.Js (UI)

- Python Fastapi (बैकएंड)

- SearxNG मेटाखोज इंजन के लिए संदर्भ भी शामिल है। इसके लिए बहुत कम विन्यास है, बहुत ही मानक डॉकर इमेज।

- एक विशेषज्ञ मोड है जो मूल से कई अनुरोध तैयार करेगा और प्रतिक्रियाओं को संयोजित करेगा। लेकिन हमारे परीक्षण में यह काम नहीं कर रहा है।

- किसी भी Ollama-मेजबान LLM का उपयोग करने की क्षमता है, चैट मॉडल के रूप में (llama3, mistral, gemma, phi3)। यह अच्छा विकल्प है, लेकिन मुझे यह अधिक लचीला होना अधिक पसंद होगा, और ओलामा द्वारा सेवा किए गए किसी भी मॉडल का उपयोग करने की अनुमति देना चाहिए।

- एम्बेडिंग मॉडल के लिए कोई विकल्प नहीं है

Perplexica और Farfalle द्वारा की गई तुलना

मैंने एक ही अनुरोध चलाया

Farfalle और Perplexica की तुलना robustness, community, support और LLM supported के आधार पर करें

दोनों Perplexica और Farfalle घरेलू ollama पर मेजबान llama3 मॉडल का उपयोग कर रहे थे।

मॉडल का पूरा नाम llama3 8b q4 है।

जो भी प्रतिक्रियाएं देते हैं, उनके बारे में 100% विश्वास न करें, बस पाठ की लंबाई, संरचना और समग्र प्रतिक्रिया गुणवत्ता देखें।

मुझे लगभग 70% विश्वास है…

Perplexica तुलना प्रतिक्रिया

Farfalle और Perplexica की तुलना

Robustness

Farfalle: 8/10 - Farfalle एक लोकप्रिय AI खोज इंजन है जो अपनी विश्वसनीयता और जटिल प्रश्नों के संचालन के क्षमता के लिए जाना जाता है। यह प्राकृतिक भाषा प्रसंस्करण (NLP) और मशीन शिक्षा (ML) में मजबूत पायदान है। यह आदर्श नहीं हो सकता है, लेकिन Farfalle की मजबूतता अच्छी तरह स्थापित है।

Perplexica: 9/10 - Perplexica Meta AI के Phi-3 मॉडल पर बनाया गया है, जो मजबूतता के लिए डिज़ाइन किया गया है। यह अस्पष्ट या अस्पष्ट प्रश्नों के लिए भी सटीक उत्तर प्रदान करने के लिए परीक्षण किया गया है। इसकी प्रश्नों को पुनर्फॉर्म करने और विभिन्न संदर्भों में अनुकूलित करने की क्षमता इसे एक मजबूत खोज इंजन बनाती है।

Community

Farfalle: 7/10 - Farfalle के पास अपनी क्षमताओं के लिए एक समर्पित समुदाय है। यह Perplexica के समान अपनाहरण के स्तर तक नहीं पहुंच सकता है, लेकिन Farfalle के उपयोगकर्ता आधार अभी भी महत्वपूर्ण है।

Perplexica: 8.5/10 - Perplexica खोज इंजनों के लिए नवाचार के अपने दृष्टिकोण के लिए व्यापक मान्यता प्राप्त है। इसका समुदाय तेजी से बढ़ रहा है, अनेक उपयोगकर्ताओं द्वारा इसकी सटीक और संबंधित परिणाम प्रदान करने के लिए उत्साहित है।

Support

Farfalle: 6.5/10 - Farfalle अक्सर प्रश्नोत्तर, दस्तावेजीकरण और फोरम के माध्यम से मूल आधार पर समर्थन प्रदान करता है। यह Perplexica के समर्थन के तुलना में अधिक व्यापक नहीं है, लेकिन Farfalle के उपयोगकर्ता आधार आमतौर पर स्वयं आत्मनिर्भर है।

Perplexica: 9/10 - Perplexica विस्तृत समर्थन संसाधन प्रदान करता है, जिसमें विस्तृत दस्तावेजीकरण, प्रश्नोत्तर और समुदाय फोरम शामिल हैं। इसके विकासकर्ता समुदाय के साथ सक्रिय रूप से शामिल हैं, जिससे उपयोगकर्ताओं को समय पर और प्रभावी सहायता प्राप्त होती है।

LLMs Supported

Farfalle: नहीं - Farfalle एक अकेला AI खोज इंजन है जो अपनी क्षमताओं के लिए बड़े भाषा मॉडल (LLMs) पर निर्भर नहीं है।

Perplexica: हां - Perplexica Meta AI के Phi-3 मॉडल पर बनाया गया है, जो एक LLM है। यह Perplexica को गहरे सीखने की शक्ति का उपयोग करके अधिक सटीक और संबंधित परिणाम प्रदान करने की अनुमति देता है।

सामान्य स्कोर Farfalle: 22/30 Perplexica: 34.5/40

इन मानदंडों के आधार पर, Perplexica Farfalle की तुलना में एक छोटा फायदा दिखाई देता है, जबकि दोनों खोज इंजनों के अपने मजबूतियां हैं, और चुनाव अंततः आपकी विशिष्ट आवश्यकताओं और पसंदों पर निर्भर करता है।

सिफारिश: यदि आप एक विश्वसनीय AI खोज इंजन की तलाश में हैं जो मजबूत NLP क्षमताओं के साथ है, तो Perplexica बेहतर विकल्प हो सकता है। यदि आप खोज के लिए एक अधिक सरल, कोई फर्क नहीं वाला दृष्टिकोण पसंद करते हैं, तो Farfalle अच्छे परिणाम प्रदान कर सकता है।

Farfalle तुलना प्रतिक्रिया

Farfalle और Perplexica की तुलना

Farfalle और Perplexica दो AI-शक्तिशाली खोज इंजन हैं जिनके नवीनतम समय में ध्यान आया है। यहां इन दो परियोजनाओं के आधार पर तुलना है: robustness, community, support, और LLM (Large Language Model) समर्थन।

Robustness

- Farfalle को स्व-मेजबान के रूप में डिज़ाइन किया गया है, जिससे उपयोगकर्ताओं के लिए अपने खोज इंजन पर नियंत्रण होता है, जिससे Farfalle एक अधिक मजबूत विकल्प होता है।

- Perplexica, दूसरी ओर, Perplexity AI के एक ओपन-सोर्स विकल्प है और इसके विकासकर्ता इसे निरंतर सुधार रहे हैं।

Community

- Perplexica के पास विकासकर्ताओं और उपयोगकर्ताओं के एक समर्पित समुदाय है जो इसके विकास और समर्थन के लिए योगदान देता है

- Farfalle के समुदाय छोटा है, लेकिन यह GitHub पर अपनी उपस्थिति अभी भी रखता है

Support

- Perplexica नियमित अपडेट और सुधार प्रदान करता है, और एक Discord चैनल भी है जहां नियमित समर्थन के बाहर विषयों के बारे में चर्चा की जा सकती है

- Farfalle का समर्थन GitHub के मुद्दों और पुल रिक्वेस्ट तक सीमित है

LLM समर्थन: दोनों Farfalle और Perplexica LLM का समर्थन करते हैं। Perplexica Ollama, एक स्थानीय LLM का उपयोग करता है, जबकि Farfalle स्थानीय और बादल LLM का समर्थन करता है।

सारांश: Farfalle अपने स्व-मेजबान डिज़ाइन के कारण अधिक मजबूत है, जबकि Perplexica एक मजबूत समुदाय और बेहतर समर्थन है। दोनों परियोजनाएं LLM का समर्थन करती हैं, लेकिन Perplexica Ollama का विशेष रूप से उपयोग करता है।

निष्कर्ष

Perplexica और Farfalle के बीच क्या अंतर है?

उत्तर:

- कुछ तथ्यीय त्रुटियों को छोड़कर, दोनों प्रणालियां Perplexica के बेहतर होने के बारे में सोचते हैं, जिसके साथ मैं सहमत हूं।

- मैं Farfalle के UI को बहुत पसंद करता हूं, हालांकि वे बहुत करीब हैं

- मैं Farfalle के विशेषज्ञ मोड के विचार को पसंद करता हूं, हालांकि मेरे वातावरण में यह काम नहीं करता है

- मैंने Farfalle चलाते समय 3 बग्स का सामना किया। Perplexica कोड अधिक बेहतर है

- एक बार सेटअप के बाद, perplexica कोई त्रुटि बिना चला

- Perplexica किसी भी Ollama-मेजबान मॉडल का उपयोग करने की अनुमति देता है। और Farfalle केवल Gemma, Llama3, Mistral और Phi3 (परिभाषित संस्करण, जो थोड़ा पुराना हैं) का उपयोग कर सकता है।

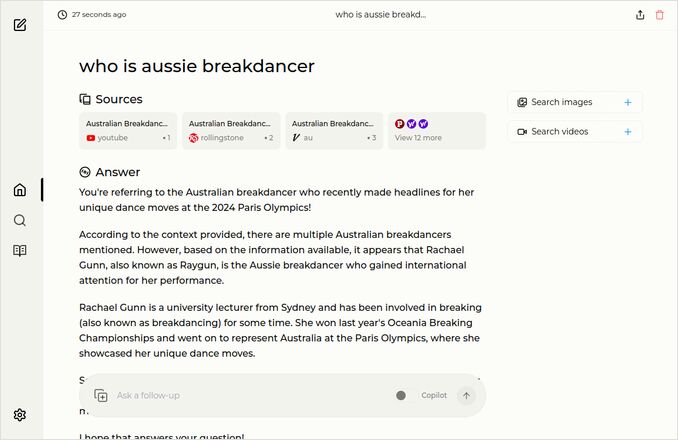

- मैं Farfalle के प्रतिक्रियाओं को अधिक पसंद करता हूं। नीचे दिए गए Farfalle चित्र को देखें। बिना उन “Accrording to the context provided” के सीधे बिंदु पर।

अधिक उदाहरण

ये एक ही प्रश्न के लिए उत्तर दिखाते हैं, जो ऑस्ट्रेलियाई ब्रेकडांसर के बारे में है।

आप जानते हैं, वह जो PhD रखता है और 0 (शून्य) अंक प्राप्त करता है और संभवतः ब्रेकडांसिंग को ओलंपिक कार्यक्रम से हटा दिया गया है।

Farfalle के उत्तर

Perplexica के उत्तर

यदि आप इस अंतिम अनुच्छेद को पढ़ते हैं (या नीचे), तो आपके द्वारा एक ही रुचि होने के लिए धन्यवाद। यह वास्तव में उत्साहजनक समय है।

एक अच्छा दिन हो!

उपयोगी लिंक

- खोज vs Deepsearch vs Deep Research

- परीक्षण: Ollama कैसे Intel CPU प्रदर्शन और कुशल कोर का उपयोग करता है

- Ollama कैसे समानांतर अनुरोधों का निपटारा करता है

- Perplexica के स्व-मेजबान - Ollama के साथ

- LLM सारांशीकरण क्षमताओं की तुलना

- LLM के लिए प्रभावी प्रम्प्ट लिखें

- नए LLMs द्वारा तार्किक अपमान पता लगाने की परीक्षण: gemma2, qwen2 और mistral Nemo

- Ollama टिप्पणी सीट

- मार्कडाउन टिप्पणी सीट

- क्लाउड LLM प्रदाता

- Qwen3 एम्बेडिंग और रिरैंकर मॉडल Ollama पर: अत्याधुनिक प्रदर्शन