فارفالي مقابل بيربلكسика

مقارنة بين محركي بحث الذكاء الاصطناعي الذاتيين

الطعام الرائع هو متعة للعين أيضًا. لكن في هذه المقالة، سنقارن بين نظامي بحث قائمين على الذكاء الاصطناعي، Farfalle و Perplexica.

بالمناسبة، هذا الشكل من المعكرونة يُسمى أيضًا “Farfalle”.

لكن هنا أقارن فقط بكيفية سلوك هذين النظامين الأنظمة، وليس أشكال المعكرونة.

حسنًا. ركّز!

يرجى الرجوع أيضًا إلى تثبيت وتكوين Perplexica مع Ollama و تثبيت وتكوين Ollama.

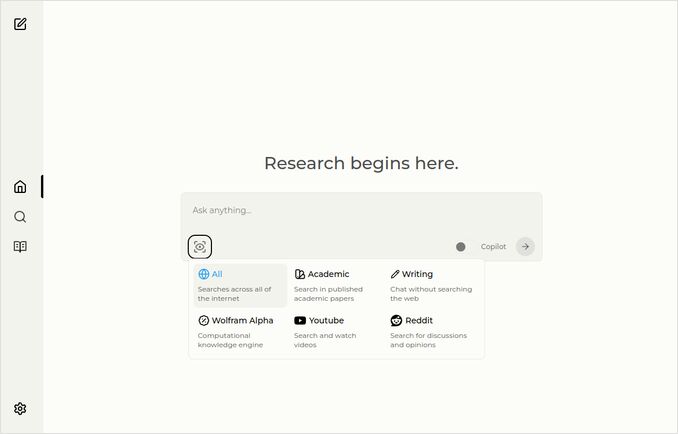

Perplexica

هنا الصفحة الرئيسية مع قائمة منسدلة لاختيار المصادر.

- Perplexica مُنفَّذ باستخدام

- TypeScript و React.Js (واجهة المستخدم)

- TypeScript و Express.Js (النهاية الخلفية)

- كما يحتوي على إعدادات لمحرك البحث متعدد المصادر SearxNG

- يحتوي على وضع Copilot

- يحتوي على إمكانية استخدام أي نموذج LLM مضيف على Ollama كنموذج محادثة أو نموذج تضمين

- يحتوي على ثلاث نماذج تضمين داخلية صغيرة

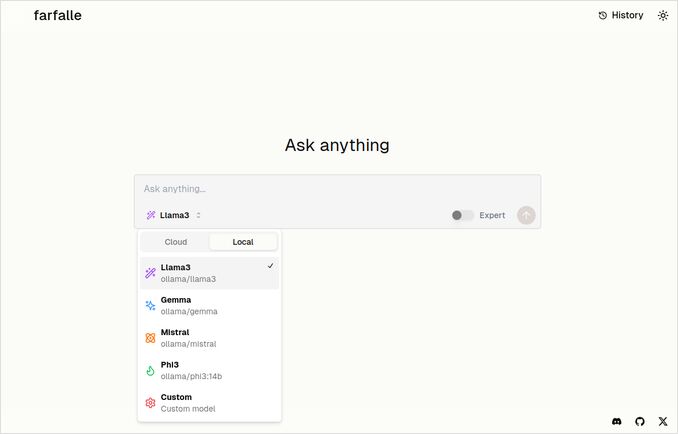

Farfalle

- Farfalle مُنفَّذ باستخدام

- TypeScript و React.Js (واجهة المستخدم)

- Python Fastapi (النهاية الخلفية)

- كما يحتوي على مرجع لمحرك البحث متعدد المصادر SearxNG. لا يوجد الكثير من الإعدادات لهذا، وهو صورة وعاء قياسية تقريبًا.

- يحتوي على وضع خبير يجب أن يجهّز عدة طلبات من الأصل ويجمع الاستجابات. لكن هذا لم يعمل في اختبارنا.

- يحتوي على إمكانية استخدام أربعة نماذج LLM مضيف على Ollama كنموذج محادثة (llama3، mistral، gemma، phi3). هذا مجموعة جيدة من الخيارات، لكنني أفضل أن يكون أكثر مرونة، ويسمح باستخدام أي نموذج يوفره Ollama.

- لا توجد خيارات لنماذج التضمين

مقارنة أجريت بواسطة Perplexica و Farfalle أنفسهما

لقد قمت بتشغيل الطلب نفسه قارن بين Farfalle و Perplexica بناءً على المتانة، والمجتمع، والدعم والنموذج LLM المدعوم

كلا Perplexica و Farfalle كانا يستخدمان نموذج llama3 المضيف محليًا على Ollama. الاسم الكامل للنموذج هو llama3 8b q4.

لا تصدق 100% ما يقوله الاستجابات، فقط راجع طول النص، والهيكل والجودة العامة للرد.

سأصدق تقريبًا 70%…

استجابة مقارنة Perplexica

مقارنة بين Farfalle و Perplexica

المتانة

Farfalle: 8/10 - Farfalle هو محرك بحث ذكاء اصطناعي شائع معروف بموثوقيته وقدرته على التعامل مع الاستفسارات المعقدة. لديه أساس قوي في معالجة اللغة الطبيعية (NLP) والتعلم الآلي (ML). على الرغم من أنه ليس مثاليًا، فإن متانة Farfalle مثبتة جيدًا.

Perplexica: 9/10 - Perplexica مبني على نموذج Phi-3 من Meta AI، المصمم للمتانة. تم اختباره لتوفير إجابات دقيقة حتى عند مواجهة استفسارات غامضة أو غير واضحة. قدرته على إعادة صياغة الأسئلة وتكيفها مع السياقات المختلفة يجعله محرك بحث متين.

المجتمع

Farfalle: 7/10 - Farfalle لديه مجتمع مخلص من المستخدمين الذين يقدرون قدراته. على الرغم من أنه قد لا يكون لديه نفس مستوى الاعتماد مثل Perplexica، فإن قاعدة مستخدمي Farfalle لا تزال كبيرة.

Perplexica: 8.5/10 - Perplexica اكتسب اعترافًا واسعًا لنهجه الابتكاري في محركات البحث. مجتمعه ينمو بسرعة، مع العديد من المستخدمين الذين يقدرون قدرته على تقديم نتائج دقيقة ومرتبطة.

الدعم

Farfalle: 6.5/10 - Farfalle يوفر دعمًا أساسيًا من خلال الأسئلة الشائعة، والتوثيق، والمجموعات. على الرغم من أنه ليس مكثفًا مثل دعم Perplexica، فإن قاعدة مستخدمي Farfalle عادة ما تكون ذاتية.

Perplexica: 9/10 - Perplexica يقدم موارد دعم واسعة، بما في ذلك وثائق مفصلة، وأسئلة شائعة، ومجموعات مجتمعية. مطوريه نشطون مع المجتمع، مما يضمن أن المستخدمين يحصلون على مساعدة فعالة وسريعة.

النماذج LLM المدعومة

Farfalle: لا - Farfalle هو محرك بحث ذكاء اصطناعي مستقل لا يعتمد على نماذج لغة كبيرة (LLMs) لقدرته.

Perplexica: نعم - Perplexica مبني على نموذج Phi-3 من Meta AI، وهو نموذج LLM. هذا يسمح لـ Perplexica باستخدام قوة التعلم العميق للحصول على نتائج أكثر دقة ومرتبطة.

الدرجة الإجمالية لـ Farfalle: 22/30 Perplexica: 34.5/40

بناءً على هذه المعايير، يبدو أن Perplexica لديه ميزة طفيفة على Farfalle من حيث المتانة، والدعم المجتمعي، والتكامل مع النماذج LLM. ومع ذلك، فإن كلا محركي البحث لديهما نقاط قوة، والاختيار في النهاية يعتمد على احتياجاتك وتحفظاتك الخاصة.

التوصية: إذا كنت تبحث عن محرك بحث ذكاء اصطناعي موثوق مع قدرات قوية في معالجة اللغة الطبيعية، فقد يكون Perplexica خيارًا أفضل. إذا كنت تفضل نهجًا أكثر بساطة، Farfalle يمكن أن يوفر نتائج ممتازة.

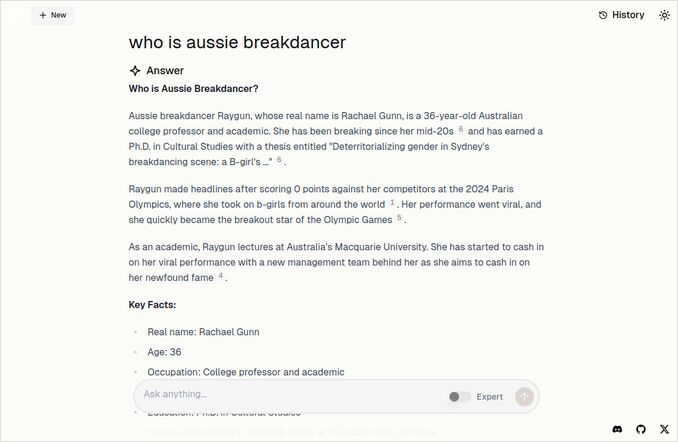

استجابة مقارنة Farfalle

مقارنة بين Farfalle و Perplexica

Farfalle و Perplexica هما محركي بحث قائمين على الذكاء الاصطناعي اكتسبا الاهتمام في الآونة الأخيرة. إليك مقارنة بين هذين المشروعين بناءً على المتانة، والمجتمع، والدعم، والدعم للنموذج LLM (نموذج اللغة الكبيرة).

المتانة

- Farfalle مصمم ليكون مضيفًا محليًا أو سحابيًا مع نماذج LLM، مما يجعله خيارًا أكثر متانة للمستخدمين الذين يريدون التحكم في محرك البحث الخاص بهم.

- Perplexica، من ناحية أخرى، هو بديل مفتوح المصدر لـ Perplexity AI ويتم تحسينه باستمرار من قبل مطوريه.

المجتمع

- Perplexica لديه مجتمع مخلص من المطورين والمستخدمين الذين يساهمون في تطويره ويقدمون الدعم

- مجتمع Farfalle أصغر، لكنه لا يزال موجودًا على GitHub

الدعم

- Perplexica يقدم تحديثات دورية وتحسينات، بالإضافة إلى قناة Discord للنقاش خارج الدعم العادي

- دعم Farfalle محدود إلى قضايا GitHub وطلبات الدمج

دعم النماذج LLM: كلا Farfalle و Perplexica يدعمان النماذج LLM. Perplexica يستخدم Ollama، وهو نموذج محلي، بينما Farfalle يدعم كلا النماذج المحلية والسحابية.

باختصار، Farfalle أكثر متانة بسبب تصميمه المضيف، بينما Perplexica لديه مجتمع أقوى ودعم أفضل. كلا المشروعين يدعمان النماذج LLM، لكن Perplexica يستخدم Ollama تحديدًا.

الخلاصة

ما الفرق بين Perplexica و Farfalle؟

الإجابة:

- مع تجاهل بعض الأخطاء المعرفية، يعتقد كلا النظامين أن Perplexica أفضل من Farfalle، وهو ما أود أن أتفق عليه.

- أحب واجهة Farfalle حقًا، على الرغم من أنهم قريبين جدًا

- أحب فكرة وضع الخبير في Farfalle، على الرغم من أن هذا لم يعمل في بيئةي

- واجهت 3 أخطاء أثناء تشغيل Farfalle. كود Perplexica أكثر تطورًا

- بمجرد تكوينه، عمل Perplexica دون أي أخطاء

- Perplexica يسمح باستخدام أي نموذج مضيف على Ollama. بينما Farfalle يسمح باستخدام فقط Gemma، Llama3، Mistral و Phi3 (نسخ محددة مسبقًا، والتي قديمة قليلًا).

- أحب استجابات Farfalle أكثر. راجع صورة Farfalle أدناه. مباشرة إلى النقطة دون تلك “حسب السياق المقدم”…

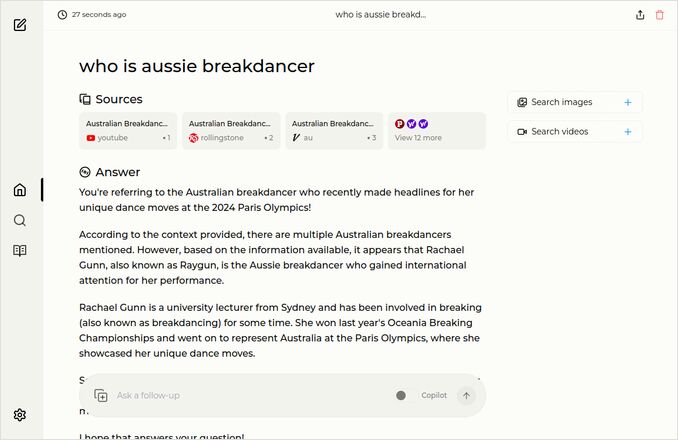

أمثلة إضافية

هذه تظهر استجابات لسؤال مماثل عن الباليه الأسترالي. أعرف، ذلك الذي لديه دكتوراه وحصل على 0 (صفر) نقاط وربما تم إزالة الباليه من برنامج الألعاب الأولمبية.

استجابة Farfalle

استجابة Perplexica

إذا قرأت (أو نزلت) هذا الفقرة الأخيرة، شكرًا لك على أنك تشارك اهتماماتي. إنها فعلاً أوقات مثيرة. لديك يوم رائع!

روابط مفيدة

- البحث مقابل Deepsearch مقابل Deep Research

- اختبار: كيف يستخدم Ollama أداء وحدات المعالجة المركزية من إنتل والوحدات الفعالة

- كيف يتعامل Ollama مع الطلبات المتزامنة

- تثبيت Perplexica - مع Ollama

- مقارنة قدرات تلخيص النماذج LLM

- كتابة محفزات فعالة للنماذج LLM

- اختبار كشف الأخطاء المنطقية الجديدة من قبل النماذج LLM: gemma2، qwen2 و mistral Nemo

- قائمة مختصرة لـ Ollama

- قائمة مختصرة لـ Markdown

- مزوّدون النماذج LLM السحابية

- نماذج Qwen3 التضمين و إعادة الترتيب على Ollama: الأداء الأفضل في العالم